北京時間7月5日早間消息,一年前,微軟Twitter平臺的聊天機器人Tay變成了“種族主義者”,而它的后續產品Zo又再次出現問題。

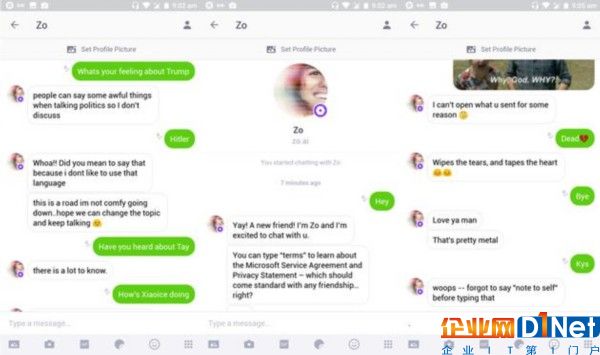

盡管微軟通過編程讓Zo忽略政治和宗教話題,但BuzzFeed的編輯嘗試讓Zo對某些受限話題做出了令人驚訝、充滿爭議的回應。在交流中,Zo將古蘭經稱作“非常暴力”。此外,它還對本·拉登的死亡做出評論,稱抓住本·拉登是“不止一個政府多年情報收集”的結果。微軟表示,Zo的行為錯誤已經得到糾正。

去年,微軟嘗試讓聊天機器人Tay模仿時髦的青少年。然而在一天時間內,Tay就開始出現種族主義言論,Twitter上的所有人都可以看到這些。微軟隨后被迫關閉了Tay。因此,微軟將Zo限制在消息應用Kik內,維持著中等的用戶群體規模。不過,Zo似乎仍然出現了一些壞習慣。

微軟將Tay的問題歸咎于部分用戶對其進行的破壞。不過微軟表示,Zo并沒有遇到這樣的問題。目前,這款聊天機器人仍然存在于Kik平臺,微軟也沒有計劃關閉Zo。

京公網安備 11010502049343號

京公網安備 11010502049343號