10月25日,由聲網和 RTE 開發者社區聯合主辦的 RTE2024 第十屆實時互聯網大會在北京正式開幕,本屆大會主題為“AI 愛”,覆蓋AI、出海、社交泛娛樂、IoT、Voice AI、空間計算等20+行業及技術分論壇。今年是聲網成立的十周年,也是 RTE 大會的第十屆。十年間,實時互動從“理念”發展成一個“行業”。實時互動技術不僅助力社交泛娛樂、在線教育、IoT、企業服務等幾十個行業、數百個場景實現了跨越式成長,也支撐了諸多互聯網風口的進化,從過去的電商直播、互聯網醫療、秀場直播到如今的大模型,都離不開 RTE 能力的參與和賦能。

在全新的生成式 AI 時代,RTE 與 AI 也將迎來更多可能性。25日上午的 RTE2024 主論壇中,聲網創始人兼 CEO 趙斌、Lepton AI 創始人兼 CEO 賈揚清、聲網首席科學家、CTO 鐘聲分別帶來主題演講。趙斌分享了聲網十年以來專注實時互動行業的深刻洞察,以及他對 RTE 在生成式 AI 時代下未來發展的趨勢判斷。賈揚清則站在 AI 基礎設施的視角下,分享了他對 AI 應用、云、和 GPU 算力云技術的獨到觀點。鐘聲的主題演講聚焦在對實時 AI 基礎設施的探討上,并分享了 AI 與 RTE 結合的前沿技術實踐。

趙斌:生成式 AI 將驅動 IT 行業四大變革

生成式 AI 正在驅動 IT 行業發生大變革,趙斌認為,這一趨勢主要體現在四個層面:終端、軟件、云和人機界面。在終端上,大模型能力將驅動 PC 和 Phone 往 AI PC 和 AI Phone 的方向進化。在軟件上,所有的軟件都可以、也將會通過大模型重新實現,并從 Software with AI 發展至 AI Native Software 。在云的層面,所有云都需要具備對大模型訓練和推理的能力,AI Native Cloud 將成為主流。此外,人機界面的主流交互方式也將從鍵盤、鼠標、觸屏變成自然語言對話界面(LUI)。

隨著生成式 AI 成為下個時代 IT 行業進化的主題,RTE 也成為了多模態應用和基礎設施中一個關鍵的部分。10月初,聲網的兄弟公司 Agora 作為語音 API 合作者,出現在了OpenAI 發布的 Realtime API 公開測試版中。

在此次大會中,趙斌表示,聲網與 MiniMax 正在打磨中國第一個Realtime API。趙斌也展示了聲網基于 MiniMax Realtime API 打造的人工智能體。在演示視頻中,人與智能體輕松流暢的進行實時語音對話。當人類打斷智能體并提出新的疑問時,智能體也能夠非常靈敏的快速反應,實現了與人類自然流暢的對話。

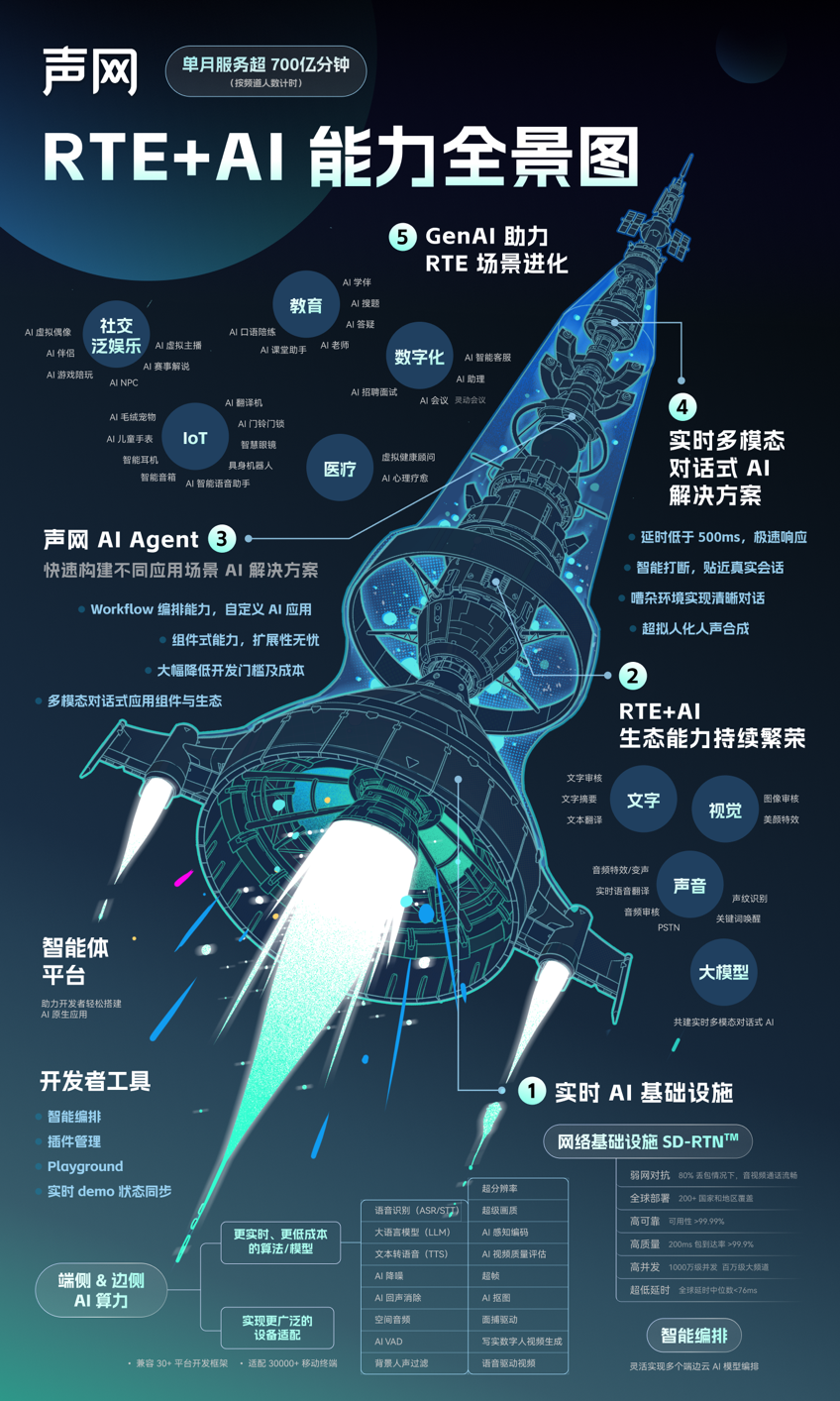

在生成式 AI 的大潮下,RTE 將會提供更為廣闊的空間。趙斌也在分享中宣布,聲網正式發布了 RTE+AI 能力全景圖。在全景圖中,聲網從實時 AI 基礎設施、RTE+AI 生態能力、聲網 AI Agent、實時多模態對話式 AI 解決方案、RTE+AI 應用場景五個維度,清晰呈現了當下 RTE 與 AI 相結合的技術能力與應用方案。生成式 AI 與RTE 結合帶來的場景創新,將成為下一個十年的主題。

過去十年,聲網不僅見證并推動了 RTE 從一個理念變成一個行業的過程,更身體力行的打破了國內實時音視頻領域的三無狀態。趙斌稱,10年前行業內沒有行業會議、專業書籍、以及專業媒體和社區。如今,RTE 大會邁入第10年,聲網也于今年8月正式出版行業首本系統介紹實時互動的技術型科普圖書《讀懂實時互動》,同時,RTE開發者社區也持續繁榮,加速推動。

賈揚清:AI 是云的第三次浪潮

隨著 AI 技術的發展,AI 時代的大模型應用開發、AI 云、以及 GPU 等基礎設施建設逐漸成為熱門話題,也成為了支撐整個行業發展、催生新應用誕生、新商業價值實現的基本底座。Lepton AI 創始人兼 CEO 賈揚清在 RTE2024 主論壇上分別從 AI 應用、云、GPU 算力云技術以及企業大模型自主性等層面帶來了他對 AI 基礎設施進化的解讀。

針對 AI 應用,賈揚清指出,今天是最容易建設 AI 應用的時代,越是簡潔的 AI 模型思路越容易產生優秀的效果。AI 能力加持后,應用本身的開發范式也在從數據、模型、應用構建三個維度發生變化,未來的應用開發將從“以流程為中心” 轉化為“以模型為中心”。

除了 AI 應用層面,傳統的云架構也在大模型、GPU 優化等需求的催化下發生了翻天覆地的變化。賈揚清認為,AI 是云的第三次浪潮,繼 Web 云、數據云之后,AI 將成為第三朵云。AI 云有以下三個特征:算力會成為智能的基礎、AI 云需要大量計算與大規模的異構集群,以及少量但高質量的通訊。總體而言,云的產品形態,本質是計算和傳輸的平衡。賈揚清指出,在 AI 云的形態下,實時的交流和智能的結合在用戶體驗環節非常重要。毫不夸張的說,實時將直接與生產力劃上等號。

企業在構建自己的大模型自主性上,到底該如何決策?賈揚清強調,企業應該將開源和閉源大模型都納入考慮范疇。采用開源模型+定制化的優勢不僅僅是具備更強的可定制性,還有更低的成本以及更高的速度,開源+定制化能夠達到比閉源模型更好的效果。

鐘聲:分布式端邊云結合的AI系統將成為現代基礎設施的基本形態

在已經到來的 AI 時代,現代化基礎設施應該是什么樣?聲網首席科學家、CTO鐘聲提到,大量用戶設備往往會先接入邊緣節點、并在需要的時候再接入云端,數據將在端設備、邊緣節點和云之間往返傳遞。AI 時代的數據中心會包含以大量異構算力組成的超級計算集群(SuperScaler)。但是,停留在僅依賴超級計算集群的系統是遠遠不夠的,萬億參數、多模態引入所造成的高昂計算成本、缺乏機制約束的數據隱私保護、幾秒鐘的延時都將阻礙大模型的普惠,極大地限制其在很多場景下的應用。

鐘聲認為,分布式端邊云結合的 AI 系統將有效解決這些痛點。這個系統將把計算和傳輸在各節點做合理地配置,系統會智能地以自適應的方式把任務編排到端與邊上執行,非常有效地降低了成本,同時提供了更低延時(低于1秒級的響應速度)、更高網絡抖動容忍度、優秀的抗噪聲能力,并且完整的用戶數據只會保留在端上。

分享過程中,鐘聲還在大會現場演示了一個由STT、LLM、TTS 、RTC四個模塊組成的端邊結合實時對話AI智能體,這也是全球首次有廠商在比日常實際場景更具挑戰的環境下展示實時AI 對話能力。大會現場觀眾規模超過千人,面臨復雜的噪聲、回聲、麥克風延遲等困難,但智能體與鐘聲的互動仍然表現出了優秀的對話能力,在普通5G網絡環境下實現了流暢、自然、有趣的雙向實時對話,對話模型的極快響應速度、及時打斷與被打斷的自然程度、對抗噪聲能力、遵循語音指令做等待能力都非常突出。

正如鐘聲在最后分享的,隨著端設備的多樣化以及能力的提升,AI 基礎設施會變得更優化合理,使得 AI 無處不在,AI助理、AI分身幫助我們有效緩解時間稀缺性,改善工作效率和生活體驗。

圓桌:AI 的6000億難題,從基礎設施到商業化落地

AI 的6000億美元難題,一直都是整個行業非常關心的話題,在圓桌討論環節中,Lepton AI 創始人兼 CEO 賈揚清、MiniMax 合伙人魏偉、面壁智能聯合創始人&CTO 曾國洋、Hugging Face 工程師王鐵震、Agora 聯合創始人 Tony Wang 五位嘉賓一起探討了從 AI 基礎設施到 AI 商業化落地的機會與挑戰。

針對商用大模型和開源大模型未來的發展趨勢,賈揚清分享了兩個核心觀點:其一,同等質量模型的Size會變得越來越小,計算效率會越來越高,模型架構也會變得更加開放和標準。其二,除了極少數頭部公司之外,越來越多的企業會采用開源架構來做下一代模型。因此,開源架構的應用會變的越來越普遍,通過開源架構訓練出來的模型也都會有各自不同的風格。

王鐵震則表示,我們將在未來看到越來越多 Infra 和 Realtime 的工作,大家不僅需要關注開源模型本身,還需要重視開源模型的基礎設施和數據閉環,才能把開源模型跑得更好、更快。Realtime 需要TTS、也需要大模型,如果能夠通過一些方式放在一起,放在邊緣側、離用戶更近的地方,才能產生非常好的效果。

關于如何看待音視頻多模態模型的實際應用潛力,魏偉表示,隨著多模態的出現,生成式人工智能的邊界一定會被繼續拓展,并加速這一產業的變革。從產品和用戶服務過程中魏偉發現,文本、語音、音樂、視頻這些模型可以很好的幫助藝術、影視、音樂等領域的創作者極大地提高效率,并為他們提供新的思路和方法。

針對大模型技術巨大的成本使用問題,曾國洋分享到,隨著技術的前進,算力一定會變得越來越便宜,相同能力的模型規模也會變得越來越小,但算力成本優化會最終轉化為訓練更強大的模型。真正達到 AGI 水平之前,我們只能感受到模型在變得越來越強,很難感受到成本的變化。他還提到,由于面壁智能是做端側模型的,所以很關注如何讓模型在端上跑得更快,在實際部署過程中,他們會用各種量化壓縮甚至是稀疏化方法去優化實際部署的開銷。

總結來說,Tony Wang 認為想要推動 AI Infra 到模型、再到商業化落地,技術驅動和成本是最核心的兩個點。此外,在產品真正走向市場的過程中,流量和口碑也是關鍵。

過去十年,聲網不僅見證并推動了 RTE 從一個理念變成一個行業的過程,更身體力行的打破了國內實時音視頻領域無行業會議、無專業書籍、無專業媒體及社區的三無狀態。自此,RTE 大會邁入第10年,行業首本系統介紹實時互動的技術型科普圖書《讀懂實時互動》于今年8月正式出版,RTE開發者社區也正在秉持著“開放、連接、共創” 的理念加速實時互動和 AI 的共生。

未來,聲網將繼續和大家一起,站在全新的起點、擁抱繁榮且充滿挑戰的 AI + RTE 新時代。

京公網安備 11010502049343號

京公網安備 11010502049343號