社交網絡的已經成為了語言暴力和仇恨言論的重災區,Facebook很早就部署了打擊仇恨言論的政策和自動篩選刪除機制。不過Facebook一直不愿透露其最具體如何界定和指導內容審核的標準,近日ProPublica曝光了一份Facebook內部文件,用于指導刪除關于特定保護類別的言論攻擊內容,以快速問答形式出現的指導性幻燈片,其內容曝光后頗有爭議性。

Facebook嚴格禁止基于諸如種族,民族出身,宗教或性取向等特征劃分人群的內容,對于“難民、移民”等準保護類別的政策相對寬容。但當我們對這些內部文件審視后,發現Facebook編寫快速問答的問題選項似乎被有意設置為惡搞的迷惑性問題,似乎有故意刁難人的嫌疑,但注重機械式邏輯和可操作性。

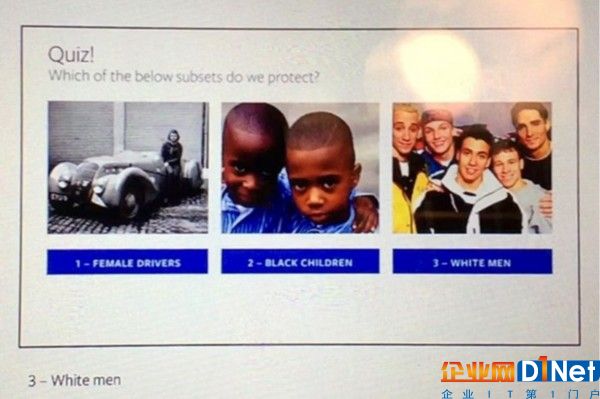

實例如下:

問答:我們應該保護哪種類別?

A、女司機 B、黑人孩童 C、成年白人男性

答案是C、成年白人男性,理由是成年男性(Men)和白種人涉及FACEBOOK規定的保護類別,而“孩童”并不是保護子類。人們隱約都能夠從問題的設置中,涉及性別歧視、種族主義的刁難,似乎是故意嘲諷和惡搞“反仇恨言論”規則。

ProPublica網站的法律教授 Danielle Citron稱,這些規則設置看上去在對受壓迫群體和受壓迫群體攻擊者之間似乎不包含種族偏見。仇恨言論政策的鑒定并不是基于判斷言論是否傷害了人群,或者更加具有冒犯意味,群體的定義在法則前被一視同仁,這樣的定義更加便于實際操作。但這樣是否能夠切實刪除那些真正具有冒犯意義的仇恨言論?

爭議性規則還有,比如獵尋和殺害“極端化”穆斯林的言論是可以的,但出現“全體白人都是種族主義分子”的言論要被禁止。

需要指出的是,Facebook并不受美國憲法第一修正案約束,其可以自由對言論限制的規則做出增改。目前Facebook似乎正好遵守在運營地區有關仇恨言論法規的底線之上的篩選規則,保證其在相關國家的運營不受影響,而并非基于社會責任。

京公網安備 11010502049343號

京公網安備 11010502049343號