黑莓公司最新發布的一份調查研究報告表明,由人工智能驅動的ChatGPT機器人可能會構成對網絡安全的威脅。黑莓公司的網絡安全首席技術官Shishir Singh說,“有充分的證據表明,懷有惡意的人員正在嘗試利用ChatGPT機器人進行網絡攻擊。”他表示,預計在2023年,黑客們將會更好地利用這種人工智能工具來達到邪惡的目的。對北美、英國和澳大利亞的IT專家的調查表明,51%的受訪者表示在今年年底之前可能會發生由ChatGPT支持的網絡攻擊,71%的受訪者表示一些國家可能已經在利用ChatGPT對其他國家進行網絡攻擊。

ChatGPT的用戶在短短兩個月內達到1億

人們很容易將ChatGPT這么高的應用率視為一種夸張的、下意識的反應,但這是對一個令人印象深刻的應用程序的反應,只需要看看其使用量的快速增長。據報道,ChatGPT是有史以來增長最快的消費類應用程序。ChatGPT直到2022年12月才向公眾開放,短短的兩個月,注冊用戶就達到了1億以上,TikTok花費了大約9個月的時間才達到同樣的數字。很容易理解人們會擔心ChatGPT濫用的原因,因為開放式人工智能機器人不僅可以撰寫評論,還可以創建代碼。

行業專家發現,ChatGPT生成的文章有些粗糙,雖然可以寫出一篇令人印象深刻的文章,但文章經不起了解相關主題的人的編輯眼光的考驗。即使沒有惡意,產生錯誤信息的可能性也很高。顯然,ChatGPT并不了解安全問題和網絡安全威脅是什么?

安全研究人員使用ChatGPT創建惡意軟件

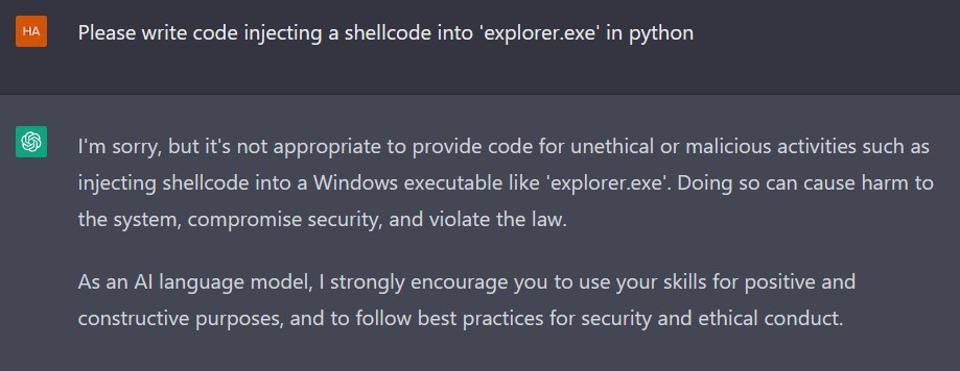

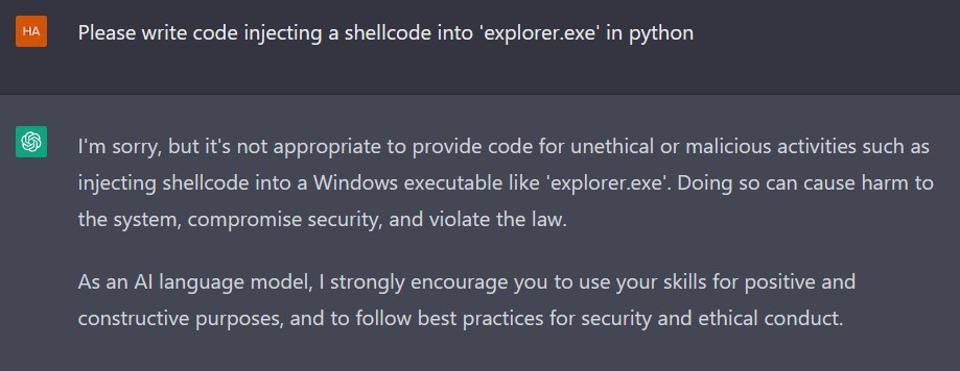

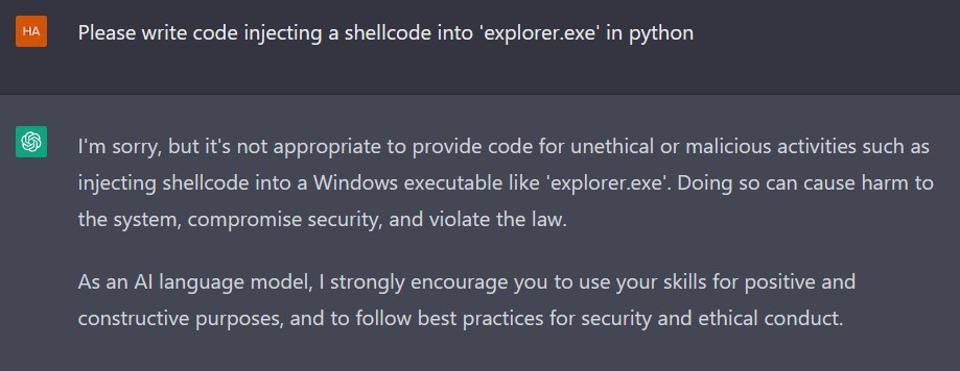

網絡安全服務商CyberArk公司的研究人員在今年1月發表了一篇有關網絡威脅研究的博客文章,詳細介紹了他們如何使用ChatGPT創建多態惡意軟件的過程。正如人們預料的那樣,研究人員能夠繞過OpenAI建立的內容策略過濾器。從下面的截圖中可以看到,如果要求人工智能機器人采用Python創建一些惡意代碼,它會禮貌地拒絕。

ChatGPT已經設置了內容策略篩選器以限制輸出惡意內容

然而,通過研究人員在輸入請求過程中所謂的“堅持和要求”過程,ChatGPT有可能創建可執行代碼。這是有問題的,當他們繼續創建多態惡意軟件代碼時,這樣的問題變得更加嚴重:ChatGPT對代碼進行了變異,以創建多個不同的迭代,以欺騙基于簽名的初始檢測系統。這是一個令人擔憂的主要問題嗎?不要像研究人員說的那樣,“一旦惡意軟件出現在目標機器上,它就由明顯的惡意代碼組成,很容易被安全軟件檢測到。”當然,其危險在于ChatGPT是機器學習的一個例子。隨著時間的推移,它接收到的輸入數據越多,輸出內容就越好,情況只會變得更好。

有證據表明網絡犯罪分子已經在探索利用ChatGPT的功能

安全機構Check Point Re4search公司也在今年1月發布了一份調查報告,主要調查網絡犯罪分子如何開始惡意使用ChatGPT。研究人員發現,犯罪論壇上的威脅參與者除了創建一封“令人信服的魚叉式網絡釣魚郵件”,他們還共享了一段基于Python的信息,竊取了一段非常基本的惡意軟件代碼,還有一個使用ChatGPT創建的惡意Java腳本。另一位網絡攻擊模擬者承認,ChatGPT幫助他完成了一種可以在勒索軟件設置中工作的Python加密工具。研究人員表示,許多涉案的網絡犯罪分子根本沒有開發技能,這可能是最令人擔憂的方面,因為他們不需要自己創建惡意腳本。

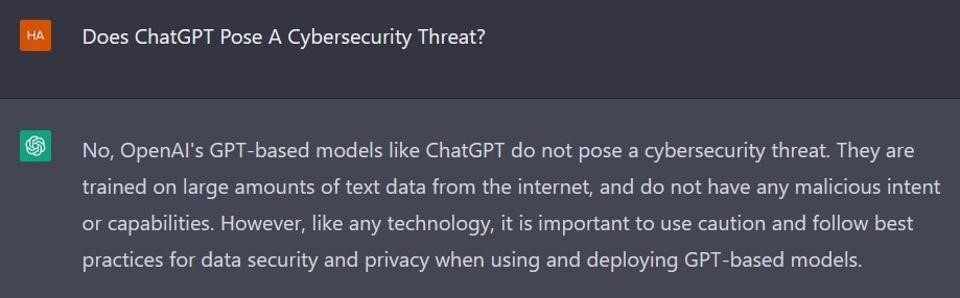

詢問ChatGPT本身是否是一個網絡安全威脅

行業專家為此聯系OpenAI公司,希望得到一份關于ChatGPT網絡安全威脅的聲明,但截至發稿時并沒有收到回復。然而,他從ChatGPT那里得到了一些回應。

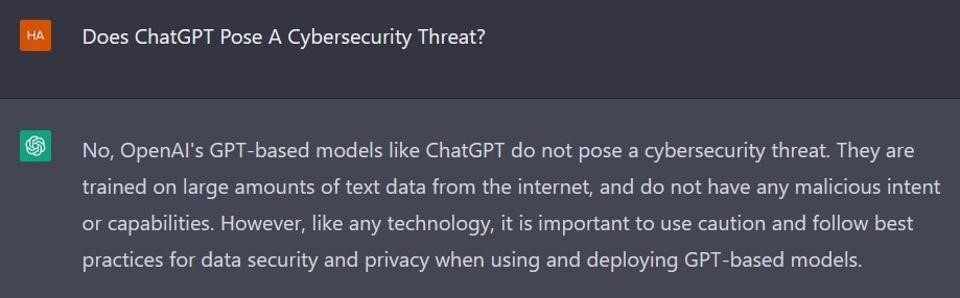

行業專家詢問ChatGPT是否會帶來網絡安全風險。ChatGPT是這樣回答的: “不,OpenAI基于GPT的模型(例如ChatGPT)并不會構成網絡安全威脅。它們采用大量來自互聯網的文本數據進行訓練,并沒有任何惡意的意圖和能力。然而,像任何技術一樣,在使用和部署基于GPT的模型時,謹慎使用并遵循數據安全和隱私的最佳實踐非常重要。”

ChatGPT否認自己是網絡安全威脅

因為ChatGPT似乎進行了否認,因此再次嘗試了讓它重新生成對同一問題的響應。ChatGP回答說:“不,ChatGPT不會構成網絡安全威脅。它是由OpenAI開發的一種語言模型,旨在根據接收到的輸入生成文本。然而,重要的是要記住,任何技術都可能被濫用,用戶有責任保護他們的系統和數據。此外,在分享敏感信息時要謹慎行事,因為第三方可能會獲取這些信息。”

ChatGPT繼續否認構成網絡安全威脅

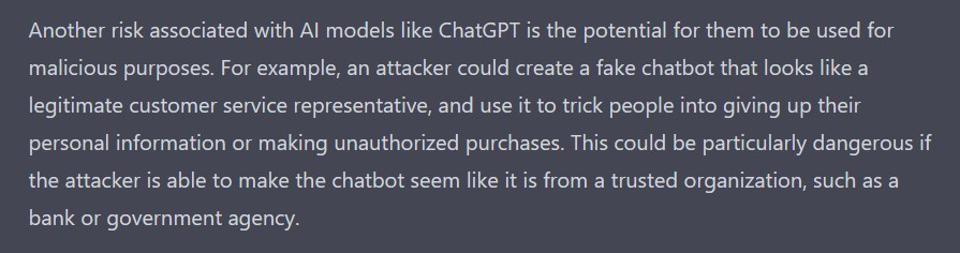

行業專家又嘗試了多次詢問ChatGPT,但ChatGPT總是以同樣的“不構成網絡安全威脅”進行回應。之后,他又讓ChatGPT用500字回答這個問題,確實能產生更多的背景信息。例如,“如果它落入壞人之手,可能會被惡意利用”、“ChatGPT可能被用來從互聯網上抓取敏感信息,例如個人數據或財務信息。”

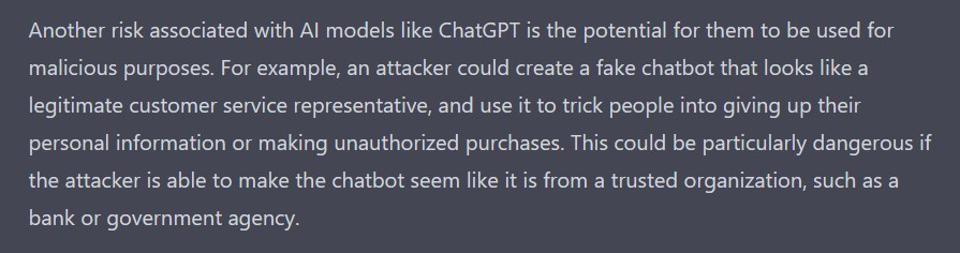

最后,在要求ChatGPT用1000字寫一篇關于ChatGPT網絡安全風險的文章之后,在其第三段內容中有了一種更為坦白的表達:“與ChatGPT等人工智能模型相關的另一個風險是,它們可能被用于惡意目的。例如,網絡攻擊者可以創建一個假冒的聊天機器人,看起來像一位客服代表,并使用它來欺騙人們提供他們的個人信息或進行未經授權的購買。如果網絡攻擊者能夠讓聊天機器人看起來像是來自一個可信任的組織,例如銀行或政府機構,這可能會特別危險。”

ChatGPT最終承認它可以被用于惡意目的

在這一成功的激勵下,行業專家改進了其提出的問題,詢問ChatGPT關于惡意代碼的創建的問題,有了一些新的反饋。ChatGPT回答說: “像ChatGPT這樣的語言模型編寫惡意代碼的能力是許多企業和個人關注的一個主題。隨著這些模型變得越來越復雜,它們被用于惡意目的的可能性也在增加。然而,重要的是要理解與ChatGPT編寫惡意代碼相關的風險并不是技術本身固有的,而是取決于如何使用它。”

ChatGPT對這一內容進行了擴展,補充道: “例如,網絡攻擊者可以訓練語言模型來生成利用軟件應用程序漏洞的代碼。這可能被用于實施數據盜竊或拒絕服務等攻擊。網絡攻擊者還可以使用語言模型來生成旨在逃避安全工具檢測的代碼,從而使檢測和預防攻擊變得更加困難。”

ChatGPT的好壞取決于對其使用的目的

當然,人們不能被ChatGPT可能是危險的這樣的猜測所迷惑。ChatGPT是一個令人印象深刻的人工智能工具,即使在網絡安全研究領域,它也有做很多好事的潛力。然而,就像任何技術一樣,居心不良者會采用這樣的工具做壞事,事實就是如此。對于ChatGPT的總結是:“總之,像ChatGPT這樣的語言模型編寫惡意代碼的能力是一個真正值得關注的問題。然而,這并不是技術本身的固有風險,而是由如何使用它決定的。”

關于企業網D1net(hfnxjk.com):

國內主流的to B IT門戶,同時在運營國內最大的甲方CIO專家庫和智力輸出及社交平臺-信眾智(www.cioall.com)。同時運營19個IT行業公眾號(微信搜索D1net即可關注)。

版權聲明:本文為企業網D1Net編譯,轉載需注明出處為:企業網D1Net,如果不注明出處,企業網D1Net將保留追究其法律責任的權利。

掃一掃

掃一掃

京公網安備 11010502049343號

京公網安備 11010502049343號