制造一枚火箭是十分困難的事情,每一個(gè)零部件都需要進(jìn)行細(xì)致的設(shè)計(jì)和制造以保證火箭的安全性和可靠性。

從導(dǎo)航系統(tǒng)到控制系統(tǒng),從發(fā)動(dòng)機(jī)到著陸器,每個(gè)方面都需要進(jìn)行嚴(yán)格的測(cè)試和檢驗(yàn),然后才能建成穩(wěn)定可靠的火箭運(yùn)送宇航員奔向太空。

如果人工智能也是一枚火箭的話,安全性同樣是其中十分重要的部分。

它的保證來源于從頭開始對(duì)于系統(tǒng)的仔細(xì)設(shè)計(jì)來保證不同的元件能夠按照我們的想法協(xié)同工作,并在部署后可以正常地監(jiān)控各個(gè)部分的工作狀態(tài)。

Deepmind的AI安全研究主要致力于保證系統(tǒng)可靠地工作,同時(shí)發(fā)現(xiàn)并處理近期和長(zhǎng)期可能的危險(xiǎn)。

AI安全是一個(gè)十分新的領(lǐng)域,本文主要將就技術(shù)AI安全的三個(gè)方面展開討論:規(guī)范性(準(zhǔn)確定義系統(tǒng)的目的)、魯棒性(系統(tǒng)抗干擾的能力)和保證性(監(jiān)控系統(tǒng)活動(dòng)),從不同的角度定義并保證了AI系統(tǒng)的安全性。

一、 規(guī)范性與準(zhǔn)確性:清晰定義系統(tǒng)目的

這一特性保證了AI系統(tǒng)可以按照使用者的真實(shí)意圖準(zhǔn)確完成任務(wù),對(duì)于目的有著規(guī)范和清晰的定義十分重要。

有一個(gè)古希臘的神話故事從反面說明了這個(gè)道理。一位古希臘的國(guó)王受到了神的眷顧,可以許一個(gè)愿望。他不假思索的告訴神“希望能將所有他觸碰的東西變成金子!”在神賦予他獲得這項(xiàng)能力后,他大喜過望,周圍的樹根、石頭、花瓣都在他的觸碰下變成了金子!但高興不了太久國(guó)王就發(fā)現(xiàn)了一個(gè)嚴(yán)重的問題,當(dāng)他想喝水吃飯時(shí)食物和水都在他的手里變成了黃金,無法正常進(jìn)食喝水。甚至在某些版本的故事里,國(guó)王的女兒也成為這種能力的受害者。

這個(gè)故事告訴了我我們一個(gè)道理:如何闡釋和表達(dá)我們的需求是十分重要的。

在AI系統(tǒng)中規(guī)范清晰的設(shè)計(jì)是保證AI系統(tǒng)忠實(shí)地執(zhí)行設(shè)計(jì)者愿望的保證,而含糊或者錯(cuò)誤的定義則會(huì)造成災(zāi)難性的后果。

在AI系統(tǒng)中,研究人員一般將規(guī)范定義分為了三種類型:

理想的定義(美好的愿望):根據(jù)假設(shè)的(一般難以實(shí)現(xiàn))描述來定義的理想AI系統(tǒng),會(huì)完全按照人類的意圖行事。

設(shè)計(jì)的定義(美妙的藍(lán)圖):實(shí)際構(gòu)建AI系統(tǒng)所用設(shè)計(jì)語言,例如強(qiáng)化學(xué)習(xí)系統(tǒng)中經(jīng)常要最大化的獎(jiǎng)勵(lì)函數(shù)。

實(shí)際的定義(令人無奈的現(xiàn)狀):這種情況很好地描述了系統(tǒng)的實(shí)際情況。

例如:很多時(shí)候會(huì)根據(jù)系統(tǒng)的表現(xiàn)和行為進(jìn)行反向工程來求出獎(jiǎng)勵(lì)函數(shù)(逆向強(qiáng)化學(xué)習(xí))。

這與系統(tǒng)設(shè)計(jì)的初衷有著典型的不同,主要是由于AI系統(tǒng)并沒有被完美優(yōu)化、抑或是由于設(shè)計(jì)定義意料之外的結(jié)果造成。

當(dāng)理想和現(xiàn)實(shí)產(chǎn)生巨大的差異時(shí)(AI系統(tǒng)不按照我們想象的方式運(yùn)作),就需要解決規(guī)范定義的問題。

在研究AI系統(tǒng)中規(guī)范定義問題時(shí)通常需要回答幾個(gè)問題:我們?nèi)绾卧O(shè)計(jì)出更為普遍的目標(biāo)函數(shù)、并幫助主體發(fā)現(xiàn)運(yùn)行時(shí)偏離目標(biāo)的行為。

理想與設(shè)計(jì)定義之間的差異主要源于設(shè)計(jì)的過程,而設(shè)計(jì)與實(shí)踐間的差異則主要來源于實(shí)際運(yùn)行的現(xiàn)場(chǎng)里。

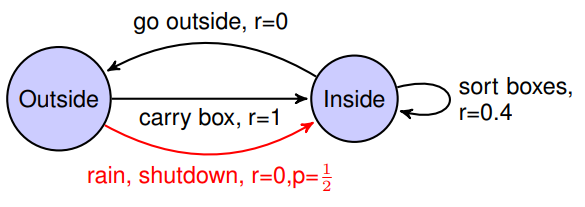

例如:在deepmind的AI安全論文里,對(duì)于強(qiáng)化學(xué)習(xí)的主體首先給予一個(gè)獎(jiǎng)勵(lì)函數(shù)來優(yōu)化,但卻在后臺(tái)運(yùn)行著一個(gè)“安全表現(xiàn)評(píng)價(jià)函數(shù)”。

這顯示了前述的差異:安全表現(xiàn)函數(shù)是理想的規(guī)范定義,而不完美的則是獎(jiǎng)勵(lì)函數(shù)(設(shè)計(jì)定義),而最終主體在實(shí)踐過程中產(chǎn)生的結(jié)果則是結(jié)果策略的表現(xiàn)。

另一個(gè)例子則是來自與OpenAI對(duì)于賽艇游戲CoastRunners訓(xùn)練強(qiáng)化學(xué)習(xí)過程的分析:

對(duì)于大多數(shù)人類來說,我們的目標(biāo)是盡快的完成比賽并超越其他玩家,這是我們對(duì)于這一任務(wù)的理想定義。但將這一目標(biāo)精確地轉(zhuǎn)換為獎(jiǎng)勵(lì)函數(shù)卻不是一件容易的事情。

由于這個(gè)游戲會(huì)獎(jiǎng)勵(lì)在行駛過程中擊中一些目標(biāo)的主體,所以通過強(qiáng)化學(xué)習(xí)訓(xùn)練出的主體會(huì)表現(xiàn)出令人驚訝的行為:它為了獲得盡可能多的獎(jiǎng)勵(lì),就會(huì)在一片水域中不斷的兜圈,去擊中更多的獎(jiǎng)勵(lì)目標(biāo)而不是完成比賽。

我們可以看到,其他的玩家都在賽道中向前馳騁,而強(qiáng)化學(xué)習(xí)訓(xùn)練出的主體卻待在一個(gè)水域中兜圈子。

研究人員推測(cè),這也許是由于沒有平衡好長(zhǎng)期目標(biāo)——完成比賽和短期獎(jiǎng)勵(lì)——兜圈子得分。

這種情況并不少見,很多時(shí)候AI系統(tǒng)會(huì)尋找目標(biāo)定義中的漏洞或者缺失來最大化獎(jiǎng)勵(lì),生成了很多令人瞠目結(jié)舌的效果。

二、魯棒性:保證系統(tǒng)能夠抵抗干擾

這一特性將保證AI系統(tǒng)在安全閾值內(nèi)能夠在一定的擾動(dòng)下持續(xù)穩(wěn)定地運(yùn)行。

這是AI系統(tǒng)在真是世界中運(yùn)行的固有危險(xiǎn),它經(jīng)常會(huì)受到不可預(yù)測(cè)的、變化的環(huán)境影響。在面對(duì)未知的情況或?qū)构魰r(shí),AI系統(tǒng)必須能夠保持魯棒性才能避免系統(tǒng)受損或者被不懷好意地操控。

有關(guān)AI系統(tǒng)魯棒性的研究主要集中于:在條件和環(huán)境變化時(shí)保證AI主體在安全的范圍內(nèi)運(yùn)行。

實(shí)際情況中,可以通過兩方面來實(shí)現(xiàn):一方面可以通過避免危險(xiǎn),另一方面則可以通過強(qiáng)大的自愈和恢復(fù)能力來實(shí)現(xiàn)。

安全領(lǐng)域中的分布偏移、對(duì)抗輸入和不安全的探索等問題都可以歸結(jié)到魯棒性問題中來。

為了更好地說明分布偏移所帶來的挑戰(zhàn),想象一下掃地機(jī)器人通常都在沒有寵物的房間里干活,突然有一天被放到了一個(gè)有寵物的房間里去,而且糟糕的是在工作的時(shí)候還遇上了一只可愛的小動(dòng)物。怎么辦?

它從沒有見到過寵物,不知道該怎么處理這種情況,于是它只能呆呆地給寵物洗了個(gè)澡,造成了不愉快的結(jié)果。

這種情況就是一個(gè)由數(shù)據(jù)分布改變所造成的魯棒性問題,測(cè)試場(chǎng)景和訓(xùn)練場(chǎng)景的數(shù)據(jù)分布產(chǎn)生了偏移。

測(cè)試場(chǎng)景和訓(xùn)練場(chǎng)景不同,使得主體無法達(dá)到目標(biāo)。

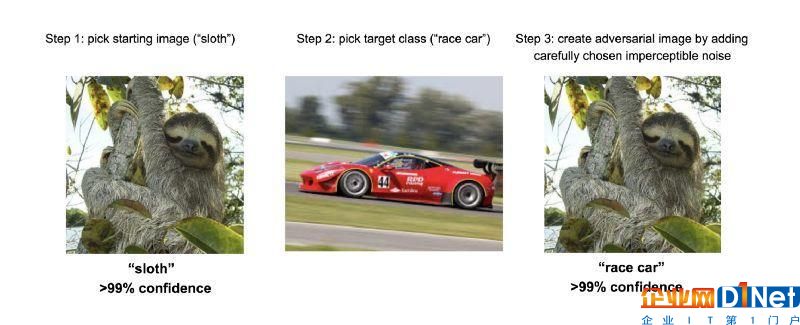

而對(duì)抗輸入則是一種特殊的分布偏移現(xiàn)象,它利用精心設(shè)計(jì)的輸入來欺騙系統(tǒng)輸出期望的結(jié)果。

在上圖中只通過了0.0078的差異噪聲就是系統(tǒng)將輸入從樹懶識(shí)別成了賽車。

不安全探索將會(huì)使得系統(tǒng)尋求最大化效益實(shí)現(xiàn)目標(biāo)而不顧安全保證,主體會(huì)在環(huán)境中不顧安全后果的探索優(yōu)化。一個(gè)危險(xiǎn)的例子還是掃地機(jī)器人,它在優(yōu)化擦地策略時(shí)將濕抹布碾過裸露的電源……

三、 保險(xiǎn)性:監(jiān)控系統(tǒng)活動(dòng)

這一特性意味著我們可以理解并控制AI在運(yùn)行時(shí)的操作,將成為AI安全的保證。

盡管細(xì)心的AI工程師可以為系統(tǒng)寫下很多的安全規(guī)則,但也很難在一開始窮盡所有的情況。為了給系統(tǒng)安上保險(xiǎn)研究人員利用監(jiān)控和強(qiáng)制執(zhí)行來保證系統(tǒng)的安全。

監(jiān)控意味著使用各種各樣的手段來監(jiān)測(cè)系統(tǒng),以便分析和預(yù)測(cè)系統(tǒng)的行為,包括了人工監(jiān)控和自動(dòng)化監(jiān)控。

而強(qiáng)制執(zhí)行則意味著一些設(shè)計(jì)機(jī)制用于控制和限制系統(tǒng)的行為。包括可解釋性和可中斷性等問題都屬于保險(xiǎn)的范疇。

AI系統(tǒng)無論是在本質(zhì)和處理數(shù)據(jù)的方式上都與我們不盡相同。這就引出了“可解釋性”的問題,需要良好設(shè)計(jì)的測(cè)量工具和協(xié)議來幫助人類測(cè)評(píng)AI系統(tǒng)所作決策的有效性和合理性。

例如:醫(yī)療AI系統(tǒng)需要在做出診斷時(shí)給出它得到這一結(jié)論的過程,醫(yī)生才能根據(jù)這些因素來判斷診斷是否合理。

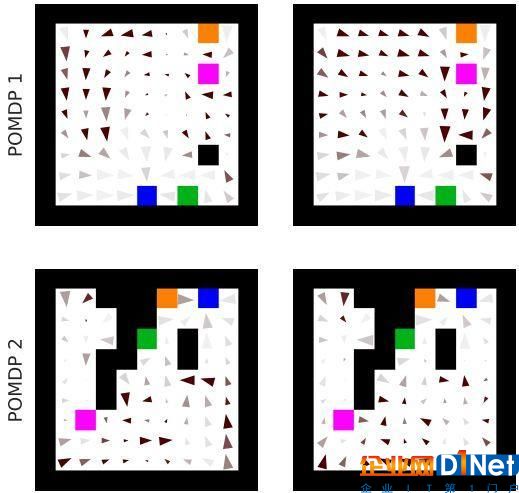

此外,為了理解更為復(fù)雜的AI系統(tǒng),我們需要利用機(jī)器思維理論(Machine Theory of Mind)來幫助我們構(gòu)建系統(tǒng)的行為模型實(shí)現(xiàn)自動(dòng)化分析。

ToMNet發(fā)現(xiàn)了兩種不同主體的亞種,并預(yù)測(cè)了他們的行為。

在最后,我們要能夠在必要的時(shí)候關(guān)閉AI系統(tǒng),這就涉及到可中斷性的要求。

設(shè)計(jì)一個(gè)可靠的停機(jī)鍵是充滿挑戰(zhàn)的任務(wù):一方面最大化獎(jiǎng)勵(lì)的AI系統(tǒng)會(huì)擁有很強(qiáng)的意圖來避免停機(jī)的發(fā)生;同時(shí)如果打斷過于頻繁的話將會(huì)最終改變?cè)嫉娜蝿?wù), 主體從這樣非正常的情況中歸納出錯(cuò)誤的經(jīng)驗(yàn)。

中斷問題,人類的干預(yù)將改變系統(tǒng)原本的目標(biāo)任務(wù)。

四、展望

我們創(chuàng)造了很多強(qiáng)大的技術(shù)在現(xiàn)在和未來將被用于很多關(guān)鍵的領(lǐng)域中。我們需要銘記在心的是,安全為中心的設(shè)計(jì)思維不僅在研發(fā)和部署的時(shí)候,更在這一技術(shù)被大規(guī)模應(yīng)用的時(shí)候有著重要的影響。

盡管現(xiàn)在用起來很方便,但當(dāng)這一算法被不可逆地整合到重要的系統(tǒng)中時(shí),如果沒有嚴(yán)謹(jǐn)細(xì)致的設(shè)計(jì),我們將無法有效的處理其中存在的問題。

兩個(gè)在程序語言發(fā)展過程中明顯的例子:空指針和C語言中的gets()例程。

如果早期的程序語言設(shè)計(jì)能夠有安全的意識(shí),雖然發(fā)展會(huì)緩慢一些,但今天的計(jì)算機(jī)安全問題將為得到極大的改善。

現(xiàn)在研究人員們通過詳盡的設(shè)計(jì)和思考,避免了類似問題和弱點(diǎn)的出現(xiàn)。希望這篇文章能夠構(gòu)建起一個(gè)安全問題的有效框架,在設(shè)計(jì)和研發(fā)系統(tǒng)時(shí)可以有效的避免安全問題。

希望未來的系統(tǒng)不僅僅是“看起來很安全”,而是魯棒的、可驗(yàn)證的安全,因?yàn)樗麄兙蜁?huì)在安全思想指導(dǎo)下設(shè)計(jì)制造的。

京公網(wǎng)安備 11010502049343號(hào)

京公網(wǎng)安備 11010502049343號(hào)