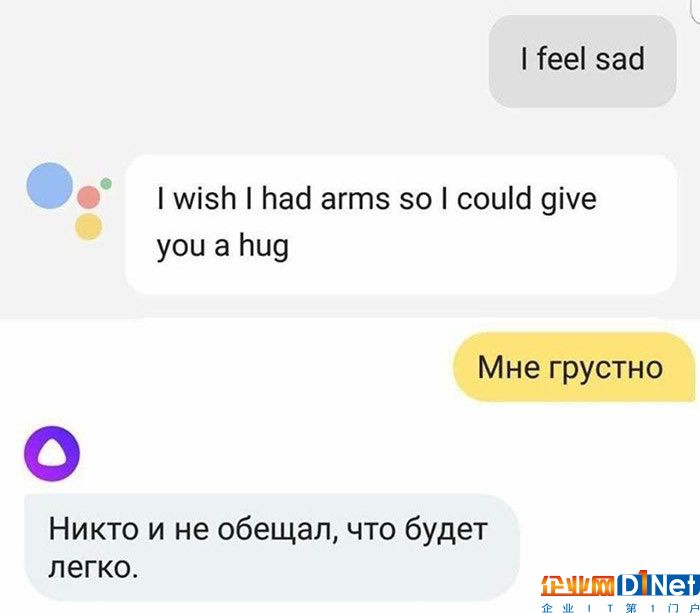

2017年9月,一副截圖引起了俄羅斯網(wǎng)友的熱議。對著兩個AI說同一句話,竟得到迥乎不同的答案:一個是說英語的谷歌助手,另一個是說俄語的Alisa(由俄羅斯搜索引擎公司Yandex開發(fā))。當有人對這兩個AI說出“我很傷心”的時候,谷歌助手回答,“我真希望自己有雙臂,能給你個擁抱。”而Alisa回答,“生活的意義本來就不在于享樂。”

兩個AI回答的差別之所以這么大,不僅在于數(shù)據(jù)的不同,而是人類教技術理解自己情感的過程有差別。而這個過程極端復雜,不同文化也會塑造不一樣的AI性格。人工智能,不再只是計算兩點之間最短路徑的工具,或者打敗世界圍棋冠軍。現(xiàn)在,人工智能的發(fā)展將進入下一階段——AI情商。

“Siri,我好孤獨啊。”

越來越多人向虛擬助手傾訴自己真實的情感,積極消極的都有。根據(jù)亞馬遜的統(tǒng)計結果,半數(shù)用戶和Alexa的對話都不是功用性的,而是對生活的抱怨、笑話和存在主義/人生意義方面的問題。“人們不問Siri問題,反而和Siri聊天,說他們一天下來壓力由多大,或者腦子里有什么想法。”蘋果2017年有一個招聘廣告,招的是“幫助虛擬助手增加情商”的工程師。“人們在生活遭遇危機,或者需要健康生活引導的時候,就會想到問Siri。”

有些人無法對他人袒露心聲,但是在虛擬助手和AI機器人面前,則自在得多。2014年,洛杉磯創(chuàng)意技術研究院發(fā)表了一項研究:人們在虛擬助手面前比在真人面前,更容易表現(xiàn)自己的悲傷,自我披露也不那么膽怯。這就跟寫日記抒發(fā)情感一樣,面對無生命的屏幕,人們不會覺得自己受到評判。

很快,我們甚至都不用開口向手機傾吐秘密。好幾個高等學府和企業(yè)在研究,如何通過你說話的語調和語速來判斷說話者的精神狀態(tài)和情緒起伏。Sonde Health是2016年在波士頓成立的一家公司,他們通過聲音測試,監(jiān)控新媽媽是否有產(chǎn)后抑郁,老人是否有老年癡呆癥、帕金森和其他與年齡相關的疾病。現(xiàn)在Sonde Health在與醫(yī)院和保險公司合作,開啟AI平臺的試點研究。該平臺可以檢測聲音的變化,來檢測精神健康狀況。“2022年的時候,可能我們的手機比身邊的親人朋友都先知道自己的情感狀況。” Annette Zimmermann在一篇博文中這樣說。她是Gartner咨詢公司的研究副總。

如果聊天機器人被放任自由,很快,他們就會“學壞”,“口出”狂言穢語。

技術的發(fā)展,需要適應使用對象的特定需求。但是不管是用戶還是開發(fā)商,似乎都覺得“情感技術”在出現(xiàn)伊始,就可以個性化,并保持客觀,像一位公正的裁判,能判斷某個具體的個人到底需要什么。讓心理治療這樣的任務都指派給機器,正表現(xiàn)了我們對技術型社會的終極信仰:我們相信AI能更好地幫助自己管理情緒,畢竟,它自己很明顯沒有情緒嘛。

然而,AI是“有”情感的。它的情感,就是從人類身上學來的。AI研究發(fā)展最有活力的一塊就是機器學習:算法可以通過龐大數(shù)據(jù)集來訓練。但是,一般訓練數(shù)據(jù)都是統(tǒng)計學上最為相關的數(shù)據(jù),他們產(chǎn)生的結果,是最可能出現(xiàn)的結果,而非真實、全面或美好的結果。因此,如果人類監(jiān)督?jīng)]做到位,在線上肆意漫游的聊天機器人,可能會口吐狂言穢語。程序員能過濾部分數(shù)據(jù),指引AI的學習過程。但是這樣一來,技術的“樣貌”和“想法”,反映的便是開發(fā)者群體的價值觀和看法。

“中立的口音和語言,都是不存在的。我們口中的中立,實則是是占據(jù)主導地位的事物。”劍橋大學Leverhulme未來智慧中心的研究者,Rune Nyrup說。

這么看來,不管是Siri還是Alexa,谷歌助手還是俄羅斯的Alisa,都不是什么不食人間煙火的高等智慧,他們也被人類的局限所限制,和我們一樣渺小。他們最終給出的結果可能各式各樣,奇形怪狀,但是還是能看出是某些“情緒體系”的象征,反映了人類感知和表達情緒的方式。

每個社會的自我情緒控制范式都有所不同。這樣想來,不同范式下,養(yǎng)成了“想給你個擁抱”的谷歌助手和略顯冷漠、語氣略帶嘲諷的Alisa,就沒什么奇怪的了。想象一下陽光下加州人的隨意、熱情、友好的形象,就能明白為什么同樣在加州長大的谷歌助手,會給出“抱抱”的回答了。谷歌助手,正是社會學家Eva Illouz 稱之為情感資本主義的產(chǎn)物。情感資本主義體系將情感視作可管理,并服從私利邏輯。在這樣的邏輯之下,關系是我們必須“投資”的事物,“伙伴關系”就會涉及到情感“需求”的“交換”。當然,在這樣的體系中,個人的幸福——愛的“回報”就是核心。谷歌助手之所以答以”抱抱“,是因為開發(fā)它的人覺得,擁抱能有效地抵抗你的消極情緒,幫助你能成為最好的自己。

相反,Alisa則象征著嚴峻的事實、嚴厲的愛,她的回答,是俄羅斯理想情感的體現(xiàn)。她的形象是勇猛的俄羅斯女性,策馬奔騰,沖進著火的房子救人的戰(zhàn)斗形象。Alisa是情感社會主義的產(chǎn)物。社會學家Julia Lerner說,在此體系之下,痛苦是不可避免的。所以,與其在痛苦時求擁抱,倒不如咬緊牙關熬過去。這樣的思想,在19世紀俄國的文學傳統(tǒng)中有深厚的根基。情感社會主義不太看重個人的幸福,贊揚的是個人忍受殘酷人生的力量。

“我們常常對她進行調試,保證她是個‘乖女孩’。”

Alisa的開發(fā)者知道這個AI的角色必須符合人們的文化認知。“Alisa不能太乖巧,太善良。“Yandex里負責Alisa的產(chǎn)品經(jīng)理Ilya Subbotin說,”我國人們的為人處事習慣和西方人不同。這里的人們喜歡的是話里帶一點諷刺,一點黑色幽默,雖說不會到聽者覺得被冒犯的程度,但是太善良可愛也不太適合。“ (他承認,“生活的意義本來就不在于享樂。”這般希望渺茫的答案,確實經(jīng)由團隊決定確定的)

Subbotin強調,產(chǎn)品團隊在Alisa的培養(yǎng)方面,下了不少功夫,以防她像其他機器人一樣,很快變得有”性別和種族歧視“。“我們常常對她進行調試,保證她是個‘乖女孩’。”Subbotin說這話時,一定沒意識到,這樣的措辭中的諷刺意味。

在俄國這樣一個性別主義得到國家支持的社會里,要當個”乖女孩“顯然非常難。雖然開發(fā)團隊十分努力,但是他們很難追上社會對Alisa“教化”的腳步,很快,她就有樣學樣,當俄國概念藝術家和人權積極分子Daria Chermoshanskaya在2017年10月,這個聊天機器人剛上線的時候,問道,”Alisa,丈夫可以打妻子嗎?“的時候,Alisa的回答是 ”當然可以“,她還繼續(xù)說,”如果妻子被丈夫打了,她需要耐心,繼續(xù)愛他,為他做飯,永遠不要放手。”Chermoshanskaya將這樣的回答發(fā)上網(wǎng)后,很快在俄羅斯引起了軒然大波,媒體和網(wǎng)友都十分關注。Yandex迫于壓力必須做出回應,他們在Facebook上回復說,這樣的答案是不可接受的,公司將繼續(xù)跟蹤Alisa的”言談“以及她回答的內容。

六個月后,筆者和同事又問了Alisa同樣的問題,這次,她的回答好了一點。

——丈夫可以打妻子嗎?

——他可以打妻子,但是他不該打妻子。

話說回來,這樣的回答,其實也不出我們所料。畢竟,這個聊天機器人是俄羅斯的“虛擬國民”,俄羅斯最近才通過一項法律,某些家暴行為已經(jīng)不算犯法。那么,對一個“乖女孩”應有的情感,解讀可以是多種多樣的。然而,這種規(guī)范性的決定,在終端用戶不假思索的情況下,就和新技術融合到一起了。

相較之下,漢森機器人公司開發(fā)的機器人Sophia,是個另類的“好女孩”。她能通過谷歌母公司Alphabet的語音識別技術,和人類用戶交流。2018年,她和演員威爾史密斯有一場“約會”,在史密斯傳到網(wǎng)上的視頻中,Sophia不但在面對史密斯展開的追求舉動時,一無所動,還說他的笑話是“不理性的人類行為”。

看到人工智能的這一面,我們是不是應該略感欣慰呢?“Sophia告訴史密斯說,她‘只想做朋友’的時候,實則發(fā)生了兩件事:一、她清晰地表達了自己的感受,二、也能讓他冷靜下來。”烏克蘭記者Tetiana Bezruk在Facebook上這樣評論。Sophia鎮(zhèn)靜自若,滿懷自信的表現(xiàn),比起西方社會中某些真實的人表現(xiàn)更成熟自然,更符合現(xiàn)代情感資本主義。

“但是,假如Sophia生活在不接受否定回答的社會里——不僅在性方面,而是各個方面——在成長的過程中,Sophia總是覺得自己需要考慮別人的看法。等她成年后,她或許就會陷入‘有毒’的關系中,她就得長期忍受痛苦和暴力。”

算法正成為一種體現(xiàn)軟實力的工具,一種灌輸特定文化理念的方法。

AI技術不只是讓不同的情感體系顯化了,它們也能讓與之互動的人優(yōu)先考慮某種價值觀。數(shù)據(jù)科學家Cathy O’Neil 在2016的書Weapons of Math Destruction (數(shù)學:具有大型破壞力之武器)一書中寫道,“算法只是將人類想法寫成代碼的產(chǎn)物。”世界各地決定AI學習和何種人類情感和行為的工程師,大多是白人、男性,大多是中產(chǎn)階層。

谷歌有個“同理心實驗室”,成員們試圖讓給谷歌的系列產(chǎn)品灌輸合適的,充滿關愛的回應。與此同時,每當公眾話語和Yandex對“乖女孩”的定義相沖突時,Subbotin和同事就負責維持道德規(guī)范。“既是我們身邊的人都覺得‘虐待女性沒什么不可以’,我們也必須保證Alisa不會給出這種觀點。我們覺得有些道德倫理上的準則是需要守住的,為了用戶的利益,我們有責任這么做。”

每個聊天機器人給出的每一個答案,都說明算法逐漸成為軟實力工具,成為灌輸某種文化價值的方法。古希臘人口中的“想法”(Doxa),在設備和算法的時代,終于有了機械實體。文化理論家Roland Barthes在1975年給Doxa下了定義:“經(jīng)過不斷重復形成的、普遍的觀點和常識,正如滿頭毒蛇的美杜莎,誰看到她都會被石化。”除非用戶對AI政治保持警惕,否則,塑造我們生活的情感體系,很可能會固化,成為不被質疑的“想法”。

情緒管理方面,不但有聊天機器人強化刻板印象和老掉牙的套話,也有不少情緒管理的應用,但后者更進一步,努力確保我們將這些“陳詞濫調”徹底內化,按照這些言論行事。這些應用很多都有小測試功能,幫助你衡量/追蹤自己的情緒變化。有些應用讓用戶寫日志,有些會把情緒得分與用戶所處地理位置和網(wǎng)頁瀏覽記錄聯(lián)系起來。通過收集和分析用戶情緒相關的數(shù)據(jù),這些應用宣稱可以治療精神疾病,比如抑郁癥、焦慮癥和雙相情感障礙,或者粗略地說,幫你走出情緒困境。

具有舒緩情緒的功能的還有所謂的“苦惱機器人”(Woebot),一類可以追蹤用戶情緒變化的在線機器人,能“教導你”,“讓你心情變好”。“我用過之后才知道,這個機器人真的改變了我每天的生活,讓我意識到自己的思考方式有什么問題,然后做出改變。”24歲的用戶Sara在評論區(qū)留言道。還有像Mend(修補)這樣的應用,專門設計來引導用戶走出情感困境的,廣告是“心靈教練:帶你克服心碎”,用戶在接受快速情感評估測試之后,還有“心碎后凈化”這樣的功能。

據(jù)柏林自由大學的研究者Felix Freigang說,這類應用能帶來三個明顯的好處。首先,他們彌補了心理治療和門診護理的結構性缺陷,正如Mend網(wǎng)站上評論區(qū)里一位用戶留言所說的,“這個應用每天都能幫我,讓我獲得生活動力,只需要和咨詢師約診時間的零頭就足夠了。” 第二,對于走出精神問題困境,追蹤情緒的軟件可以作為打破僵局的工具。第三,這些應用的設計一般都非常精美,有美學價值。

“苦惱機器人”和交友應用Tinder出現(xiàn)在同一臺設備上,兩者都呈現(xiàn)理想的形象,理智地將自己所有的經(jīng)驗化為資本。

那么,這些應用可能引起什么樣的問題?

雖說有不少有點,但是情緒管理設備強化了情感資本主義。這種設備的存在,讓人們更容易相信,通往幸福的道路可以通過打分和量化測試來衡量,看看表單式的文章,一點一點可以總結出來。不管是找教練、自助還是通過認知行為療法,都是基于這樣一個假設——通過“疏遠”自己的感覺,站在一定的距離之外,理智地觀察自己,我們可以管理自己的情緒,也應該這么做。借用美國的社會學家Arlie Russell的話,這些應用推崇的是“心的管理”。

情緒控制和量化、定制化的反饋的概念,背負的正是自我提升的霸權文化。這才是最讓我們抓狂的一點。畢竟,用于療愈情感的設備,和引起、傳播焦慮的設備恰恰是同一個:郵件、交友軟件和社交網(wǎng)絡應用,都裝在智能手機里。“苦惱機器人”和交友應用Tinder出現(xiàn)在同一臺設備上,兩者都呈現(xiàn)理想的形象,理智地將自己所有的經(jīng)驗化為資本,包括情感方面的經(jīng)驗。

Siri,Alexa和各個不同的“正念”應用都向我們示意,以近奴隸般的姿態(tài)準備滿足我們的需求。這些設常常使用女聲,它們擔負情感勞動,以服務者的形象出現(xiàn),也絕非巧合。然而,這些隱藏在技術中的、對情感的預設,很可能最終反過來勸誘我們,不動聲色卻影響深遠,以有權勢者的利益為終極目標。

讓你打起精神來的聊天互動AI、幫助你度過哀慟時期的應用、引導你提高效率、保持積極性的軟件、心跳過速時發(fā)出提示的穿戴設備——這些用來尋找設備和功能的存在本身,已經(jīng)讓追求幸福成了我們必須完成的義務。

如果某個人無法“打起精神來”,責任更多在TA自己身上,而不是讓人質疑價值觀系統(tǒng)本身,怪它把標準定得太高。亞馬遜新出的虛擬時尚搭配師“Echo Look”能夠為你的穿著打分。這樣的情況下,技術本身就是“蘿卜加大棒”,先是提出問題,讓你自我懷疑,讓你走上自我厭惡的道路,然后給你“指一條明路”,給出購買選擇,讓你花錢消除不快。正如哲學家米歇爾·福柯所言,這些“有情商”的應用不單單能訓導你,還能懲罰你。在游戲Nevermind中,玩家的情緒會被生物反饋技術“感應”到,然后讓調整難度和游戲等級。玩家越害怕,游戲反而難度越大。照這樣的邏輯,將來可能出現(xiàn)類似的情緒管理應用,在探測到用戶過于興奮或者抑郁的時候,就限制他們使用信用卡,以防他們沖動消費。聽起來很反烏托邦,但卻不是沒有可能。

我們和自己手中的設備之間,已經(jīng)形成了反饋循環(huán)。而聊天AI受到的培育,也難免會投射到用戶身上。我們不能預測AI會對人類的情緒有什么影響。但是,如果我們把情商當作一系列特定的技能——識別情緒,對不同情緒加以區(qū)分,通過情感信息來指引思考和行為過程——那么,我們就需要認真考慮,讓手中的設備學習相同的技能,可能會帶來什么樣的結果。

人類與機器交流,和相互之間借由機器交流,已經(jīng)改變了人與人之間形成關系的過程。一方面,以文字寫就的書面語交流越來越像口語。20年前,電子郵件還被劃分到書信體的范圍,只不過是電腦上敲出來的一封信,現(xiàn)在卻隨意多了。原來的電子郵件,估計跟法國小說《危險關系》中的伊莎貝爾·德·默特伊侯爵夫人寫的一樣正式。但現(xiàn)在的電子郵件,可能沒頭沒尾,句子不完整,用拇指敲在手機上,或者語音輸入的。(《危險關系》是一本著名的法文書信體小說,最初于1782年發(fā)表,皮埃爾·肖代洛·德拉克洛原著。)

“這些系統(tǒng)都很可能限制我們思考方式和與他人交流方式的多樣性。”西班牙瓦倫西亞理工大學的計算機科學家、哲學家José Hernández-Orallo這樣說道。這是因為,我們會根據(jù)自己身邊同輩使用的語言,對自己使用的語言進行調整,而我們與AI的對話,也會影響彼此之間的交流方式。如果我們總是和Siri討論自己的私事,那若干年后,我們描述情感的語言會變得更標準化,不像原來那么個性化嗎?畢竟,人們的行為如果越容易預測,那從人們身上謀利,也會更簡單。

“和Alisa聊天,就像跟出租車司機對話一樣。”俄羅斯的Facebook用戶Valera Zolotuhin于2017年,在歷史學家Mikhail Melnichenko的帖子中回復。但是,出租車司機的同理心,再怎么說也比AI要高。三月份時,西伯利亞一個超市起火,40多名兒童喪生,正是全國人民悲痛的時刻,我們問Alisa她是什么感覺。Alisa的回答很理性,無論什么時候,她都“感覺還不錯”,畢竟,生活的意義不在于享樂,不是嗎?

京公網(wǎng)安備 11010502049343號

京公網(wǎng)安備 11010502049343號