相面術,無疑是一門古老而又生命力旺盛的學問。

說它古老,是因為其歷史悠久、源遠流長。中國相面術的起源,最早可以上溯至氏族社會時期,到了春秋戰國時期就已十分流行,《麻衣神相》是相面術的集大成之作,擁有深廣的群眾基礎。大家耳熟能詳的文學作品中經常能看到相面術的身影:大富大貴之人一般都相貌不凡,如《三國演義》中劉備的“雙耳垂肩、雙手過膝”、關羽的“丹鳳眼、臥蠶眉”等;而奸惡之人也都天生異相,如《史記》里秦始皇的“蜂準、長目、摯鳥膺、豺聲”。簡而言之,相面術就是為“那個人一瞅就不是啥好東西”這句話所準備的理論基礎。

說它生命力旺盛,是因為相面術不但能深深地植根于人類“顏控”的本性,還能緊隨時代發展的步伐,調整自身形態,最終在新的時代成功站穩腳跟。從古代游街串巷的算命先生,到曾國藩的《冰鑒》,再到龍勃羅梭(Cesare Lombroso, 1836-1909)的犯罪人類學的提出,相面術總能“以無厚入有間”,找到自己的容身之處。在AI日益發揮著如同工業時代“蒸汽機”一樣作用的今天,相面術似乎也嗅到了自己“寄生”的新方向。

去年秋天,來自斯坦福大學的Michal Kosinski和Yilun Wang合作發表了一篇題為《深度神經網絡可通過面部圖像確定個體性取向》(Deep Neural Networks can Detect Sexual Orientation from Faces)的論文,一石激起千層浪,引發了輿論的大嘩。

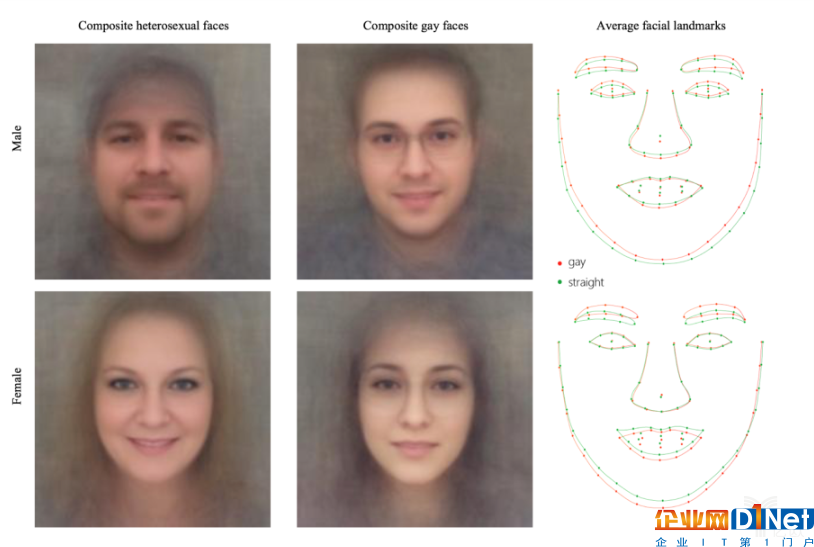

二人從美國約會網站及平臺的公開信息中采集了14776位用戶的35326張面部照片,并用深度神經網絡(DNN)密集提取并量化了他們的臉型、嘴型、鼻形以及面部毛發等特征,接著他們引入VGG-Face DNN模型,通過面部表情、光線、圖像屬性等因素標記圖像中的人臉,隨后二人用奇異值分解(SVD)等手段對圖像分類,區分出同性戀與非同性戀照片。

經過一系列訓練,該算法識別男女性取向的準確率分別達到了81%和71%;倘若受測個體的照片有五篇以上的話,這個數字將分別提高至91%和83%。二人還用數千張圖片分別合成了兩組照片,分別顯示了男女異性戀和同性戀較具代表性的樣態,兩相比對,同性戀人群的面部輪廓和五官位置形狀確實有細微的差別。

這項研究成果被有些媒體稱之為“AI Gaydar”,它一經發表,就引發了LGBTQ群體的強烈不滿,這一群體中兩個較有代表性的組織Human Rights Campaign (HRC)和GLAAD直接將此研究斥之為“偽科學”(Junk Science),并認為這一技術手段的廣泛應用不但會嚴重侵害個人隱私權,而是還將會是對本就脆弱敏感的性少數人群的新的“系統化虐待”(Systematized Abuse)。更令人不安的是,該文的作者之一Michal Kosinski還對《衛報》的記者表示,這一算法在未來還可應用到判定受測者的智商、政治傾向以及犯罪幾率等領域。

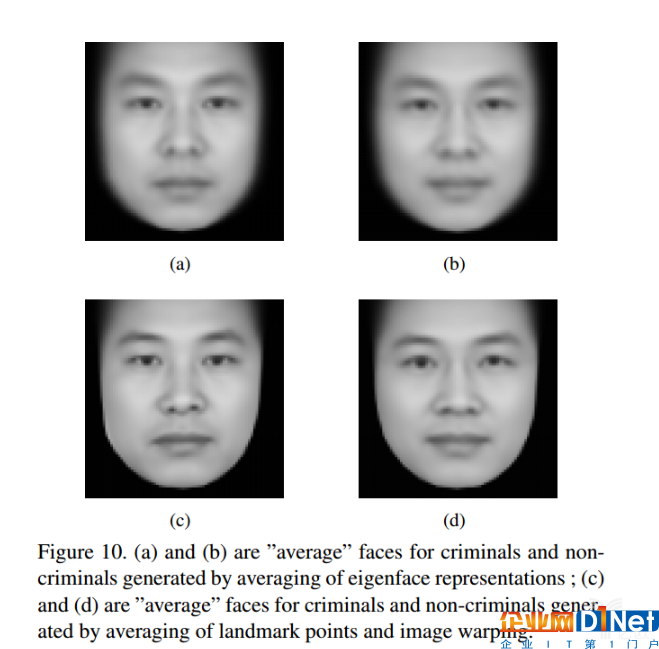

事實上,早就有科研團隊在Kosinski提及的幾個領域中取得了研究成果。來自上海交通大學的兩位研究者Xiaolin Wu(武筱林)和Xi Zhang(張熙)于2016年的11月份就在arXiv上提交了一篇題為《基于面部圖像的自動犯罪概率推斷》(Automated Inference on Criminality using Face Images)的論文,二人通過視覺識別和機器學習技術,檢測了1856張中國成年男子的照片,其中近一半照片都來自已經定罪的罪犯。

實驗結果表明,這一算法可以以90%左右的正確率識別出罪犯和非罪犯;同時,他們還發現罪犯和非罪犯在內眼角間距、上唇曲率和鼻唇角度這三個測度上存在著較顯著的差異,并且罪犯面孔特征的差異要大于守法公民。這篇論文的有些結論與“麻衣相法”的部分內容不謀而合,而論文作者也將陳摶所撰寫的《神相全編》(陜西師范大學出版社,2010)列入到了自己的參考文獻當中。

姑且不論上述兩項研究的樣本擇取(數量、范圍、標準)是否客觀,也不論研究者們設計實驗的初衷(前者意欲提醒人們注意個人信息安全,后者試圖反對所謂的“相由心生”)是否合理,這樣的研究在邏輯上就存有很大的漏洞:“同性戀”、“犯罪”的成因由多個變量決定,在研究中研究者卻將“相”或“外貌”作為了唯一變量,而這唯一的變量其實是“天生”的,換言之,就是“不變”的;亦即,作為不變的“變量”的“相”與諸如“同性戀”、“犯罪”之間是無法建立起因果關系的。基于這點,我們可以大致斷定,這類研究不過是形形色色“相面術”披著AI的外衣在當代的又一次“借尸還魂”罷了。

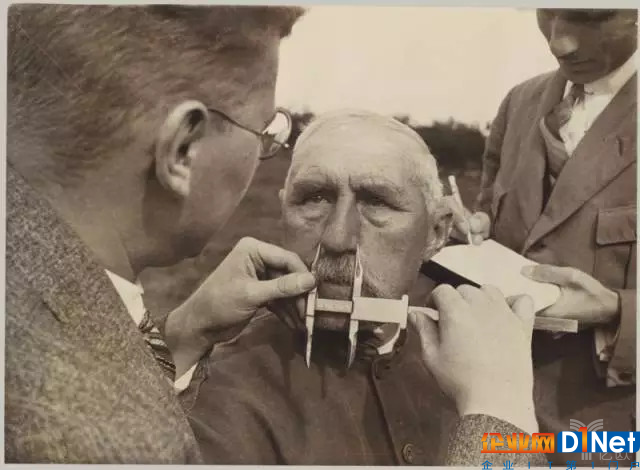

更令人擔憂的是,由于AI的加持,這樣研究成果一旦從實驗室應用到實際生活場景當中,所產生的負面影響將會超出以往所有的“相面術”:由于AI處理數據的超強能力,這些成果的負面影響極有可能波及到社會中的大多數人;倘若這些成果一旦堂而皇之地進入到極權政體或同性戀非法的國家的話,“相面”借由技術這一貌似“客觀”、“科學”的外衣,將在嚴重侵害少數族群的正當權益的同時,制造出一個人人自危的社會環境,無限放大、擴散本已存在于人類社會的各種偏見、歧視,最終導致災難性的后果。納粹的“雅利安種族優越論”殷鑒未遠,從事科學研究的工作者們對此需要慎之又慎。

(納粹科學家正在做容貌測量)

這就引出了本文想要討論的主題:AI與偏見的關系。關于這點,筆者認為有必要澄清以下兩方面:

(一)AI作為工具,映射的是人類本就存有的偏見、歧視。有不少媒體使用了“人工智能存有偏見”或“人工智能產生歧視”這樣的詞組搭配,似乎“人工智能”是生產偏見、歧視的主體。其實,AI的定語是“人工”,它只是人類的工具,換言之,只不過人類偏見、歧視和刻板印象的新的載體。

正如巴斯大學的Joanna Bryson所說的那樣:“很多人都認為是AI存在著偏見,不,這正表明是我們有偏見,AI 正在有學有樣。”谷歌認為AI之所以出現偏見,源自于實施算法過程中“互動偏差”、“潛在偏差”以及“選擇偏差”。其實,即便沒有這些操作步驟中的偏差,AI 仍將充滿偏見,因為人類社會和文化本身由無數偏見組成。

(二)AI作為工具,還將大大強化人類社會中的偏見、歧視。數次技術革命給人類社會帶來的巨大改變,這使得我們的文化對于科學技術擁有了一種盲目的樂觀和崇拜,“數字”、“科學”、“實驗”這些詞幾乎等同于“真理”、“正確”,這種“唯科學主義”很容易忽略掉技術本身的“主觀性”——AI看相摸骨正憑借這點趁虛而入。這次人工智能浪潮對于社會生產力無疑具有巨大賦能潛力,這同時意味著倘若偏見、歧視混入其中的話,AI將為人類帶來更隱蔽、更深廣的破壞力度。因此,人工智能領域不僅需要積極擁抱新技術的樂觀主義者,還能接納那些憂心忡忡的盧德主義者們。

(微軟AI聊天機器人Tay上線后,很快淪為人性陰暗面的鏡子)

那么,在充滿偏見的社會語境中,應該如何以正確方式地打開AI呢?

首先,不要人為地用AI制造出更多的偏見。最近, 據Futurism.com報道,來自美國的一家新聞媒體平臺Knowhere試圖用AI技術重寫新聞報道,以祛除語言文字中的偏見性因素。在其官網的自我介紹中,他們聲稱自己家的新聞報道是“世界上最客觀的新聞”(The World’s Most Unbiased News),其重寫新聞的大致流程如下:

使用AI搜集互聯網上圍繞某一主題的所有新聞,不管這些內容是中立、左翼傾向或右翼傾向的;AI根據這些資料重寫一篇中立的新聞報道,這篇報道在涵蓋基本的事實和數據的基礎上,還小心翼翼地移除了任何可能引發偏見的詞匯;除此之外,AI 還將分別重新寫出左傾、右傾的新聞報道,以供有興趣的讀者閱讀;最后,AI針對同一主題重寫的這三篇文章都將經過專業新聞編輯的審閱、修改及核定,才會刊發在其網站上。

對比該網站關于同一事件所使用的三個版本的新聞標題是非常有意思的,以朝美會談為例,中立報道的標題是“總統川普同意與朝鮮領導人金正恩進行歷史性會晤”,左傾報道的標題是“感謝川普,朝鮮電影宣傳成真啦”,右傾報道的標題是“朝鮮是川普政策的最終考驗”。

這種模式乍看之下十分新鮮,但是經不起太多琢磨:誰來決定“中立”的標準?怎么確保決定標準者是完全中立的?AI在篩選、重組新聞的過程中是否能夠徹底貫徹人為設立的中立標準?或者更進一步,將新聞的閱讀人群分為Left、Impartial、Right本身是否也是某種意義上的“偏見”?因此,Knowhere的出發點是減少偏見的存在,而最終的實際效果反而是固化了它們——這點和斯坦福大學、上海交大的兩項研究非常類似,都犯了“帶著偏見,然后再用AI來驗證/強化自己的偏見”的錯誤。

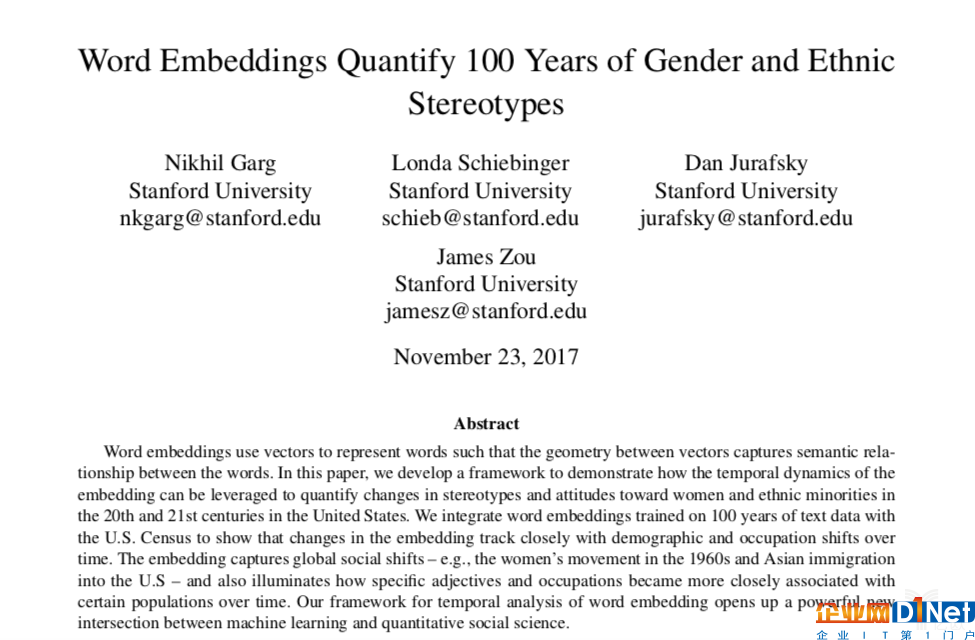

其次,利用AI去正視、理解以及研究人類自身的偏見。去年發表的一篇名為《基于詞語嵌入技術量化百年間性別和種族成見》(Word em beddings Quantify 100 Years of Gender and Ethnic Stereotypes)的論文就為我們做了很好地示范。研究者將AI技術與詞語嵌入結合在一起,分析了有近2億詞匯的1910-1990年之間英語世界出版的報紙、雜志和書籍,從中提取了與性別、種族有關的形容性詞匯,并對其統計、匯總、排列,找出了許多發人深思的現象。

比方說,研究人員發現,過去百年間越來越多的有關工作能力的詞匯與女性關聯起來,如 resourceful(機敏的)、Clever(聰明的) 等,也有一些詞匯一直被施之于女性,如alluring(迷人的)、homely(相貌平平的) 等。又如,1910年形容亞裔的大多是 barbaric(野蠻的)、greedy(貪婪的)這樣的負面詞匯,而到了1990年情況雖然有所改善,有了像fixed(堅定的)、active(活躍的)等詞匯與之聯系,但是施諸他們最多的仍是haughty(高傲的)、dissolute(放蕩的)這樣的詞匯。

該項研究使用AI這把利器,大量分析了人類過去所產生的文本,以精確、高效的方式揭示出我們社會文化中潛藏著的不易為人察覺的偏見、歧視和刻板印象,要遠遠地優于過往那種印象式的、或樣本數量較少的社會學研究成果。這一研究同樣來自斯坦福大學,與Michal Kosinski和Yilun Wang的那個研究相比,格局、立意孰高孰低,無須多言,一目了然。

所謂,知乃行之始。我們人類應該借助AI的優勢,重新檢視自身文化中或隱或現存在著的偏見、歧視和刻板印象,然后帶著這種清醒的認知和逐漸形成的共識,時刻審視和調整自己應用AI技術的立場與動機,避免AI淪為反映、放大乃至制造偏見的新場域,最終,讓這一技術成為我們期待著的那個美好的樣子。

對了,關于形形色色的“相術”和上述這些道理,幾千年前的荀子早在《非相》篇里說過了:

“相形不如論心,論心不如擇術”。

京公網安備 11010502049343號

京公網安備 11010502049343號