事實上,這種缺乏信任是眾所周知的許多人工智能工作失敗的核心之一:尤其是IBM Watson腫瘤解決方案(Watson for Oncology)。

專家們很快就解決了這個問題。“IBM試圖將其超級計算機程序推廣給IBM Watson腫瘤解決方案(Watson for Oncology)是一場公關災難,”Google和Avantgarde Analytics創始人的UX研究員Vyacheslav Polonski博士說。 “ Watson腫瘤解決方案的問題在于醫生根本不相信它。”

當Watson的結果與醫生的結論達成一致時,才能被醫生認可,但并沒有幫助達到診斷的層面。而當Watson的結論不統一時,醫生們只是認為IBM Watson的結果是錯誤的。

但如果醫生知道它的結論如何得出的,結果可能會有所不同。“人工智能的決策過程通常對大多數人來說太難理解,” Polonski博士說道。“與我們不理解的事物互動會讓人引起焦慮,讓我們有種失控感。”

需要解釋性

如果腫瘤學家已經了解Watson如何提出答案的——業界稱之為“可解釋性”,那么他們的信任程度可能會更高。

在醫療保健以外的許多情況下,可解釋性現已成為人工智能的關鍵要求。以Twitter為例,“我們需要更好地解釋我們的算法是如何工作的。理想情況下打開它們,以便人們可以真正看到它們的工作方式。對于任何人來說這都不容易,”Twitter首席執行官杰克·多爾西說。“事實上,人工智能的整個研究領域稱為'可解釋性',試圖理解如何使算法解釋他們如何做出決策。”

在其他情況下,人們呼吁AI做出生死攸關的決定。在這種情況下,可解釋性絕對至關重要。

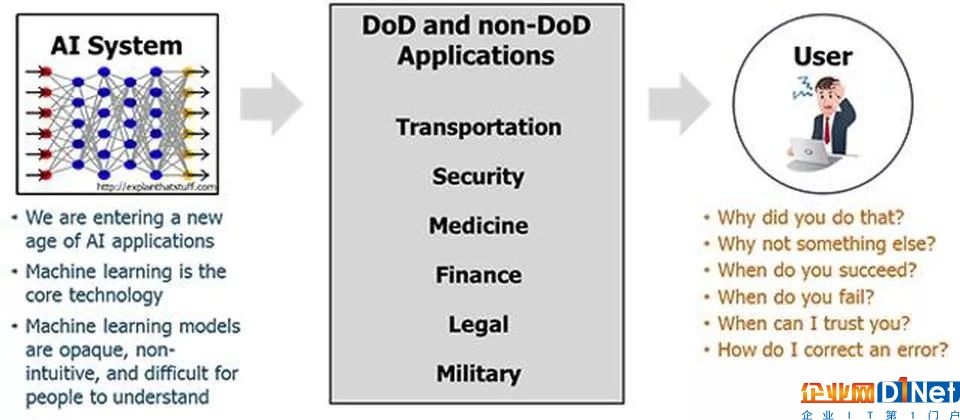

因此,美國國防部(DoD)正在投資解釋性人工智能(XAI)并不奇怪。“可解釋的人工智能——特別是可解釋的機器學習——如果未來的戰士要了解,適當信任并有效管理新一代人工智能機器合作伙伴,將是必不可少的,”國防高級研究計劃局(DARPA)項目經理David Gunning解釋道。“新的機器學習系統將能夠解釋他們的理由,描述他們的優勢和劣勢,并傳達他們對未來行為的理解。”

然而,醫療保健仍然是AI最有前途的領域之一。“可解釋的AI對我們醫療保健來說非常重要,實際上彌合了這個差距,無法了解可能會發生什么,可能會對人類的健康產生什么影響,并且實際上作為一種工具為臨床醫生提供服務,使他們真正感到舒適,并了解如何“使用人工智能”。聯合健康集團OptumLabs應用數據科學中心副主席Sanji Fernando表示,“這就是為什么我們認為學術界,學術機構,大公司以及聯邦政府內部都有一些令人驚奇的工作要做,以安全地批準這種決策。”

可解釋性權衡

雖然像DARPA這樣的組織正在積極投資XAI,但是有一個懸而未決的問題是,這些努力是否會降低使AI算法更好的核心優先級。

更令人擔憂的是:我們是否需要“弱”AI算法以使其可解釋?加利福尼亞大學歐文分校計算機科學助理教授Sameer Singh指出:“算法越準確,解釋就越困難,尤其是深度學習。”“計算機越來越成為我們生活中更重要的一部分,隨著時間的推移,自動化將逐漸得到改善,因此了解為什么這些復雜的AI和ML系統正在做出他們的決策變得越來越重要。”

因此,一些人工智能研究工作可能與其他人進行交叉目的。“系統越復雜,它的解釋就越少,”奧塔哥大學博士后研究員,可解釋人工智能研究員John Zerilli說。“如果你希望你的系統可以解釋,你將不得不使用一個不那么強大或準確的簡單系統。”

然而,DARPA投資于其所謂的“第三波AI系統”的20億美元可能足以解決這種權衡問題。“XAI是當前DARPA少數計劃之一,旨在實現'第三波AI系統',其中機器了解其運行的環境和環境,并隨著時間的推移構建基礎解釋模型,使其能夠表征現實世界現象,”DARPA的Gunning補充道。

京公網安備 11010502049343號

京公網安備 11010502049343號