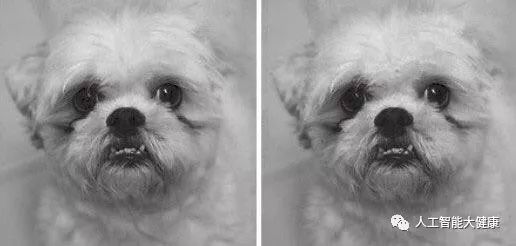

關于人工智能在推理方面的錯誤,一個由美國高等學府和社會科研機構組成的團隊做了一個非常有趣的實驗。工作人員先按照一定的標準開發出了一套可以識別圖像文字的神經網絡模型,然后他們將經過特殊化處理的圖片錄入到這個模型當中去,命令人工智能系統對該圖片進行識別。如圖所示,以人類的肉眼來看,這兩張圖片應該是不存在特征差異的。

但是對于這一套配備了特殊神經網絡的人工智能來說,最終得到的結果卻是令人大跌眼鏡的:在本次測試當中,AI系統將左邊的圖片認定為“狗”,而右邊的圖像則被判定為“鴕鳥”。實際上,這兩張圖片之間僅僅是存在細微的像素差異,而鏡像本體和所使用的拍攝器材,都是完全一致的。這就是說,在本次實驗當中,圖片像素的差異是誤導人工智能進行錯誤推理的直接原因。

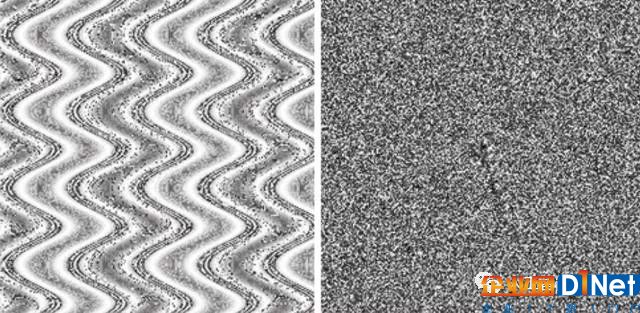

與此類似,美國懷俄明大學計算機系助理教授杰夫·克魯聯合另外兩名研究者——阮昂和杰森·約辛斯基,共同論著了一篇關于人工智能的文章。在這篇名為“人工智能其實很好騙”的文章當中,克魯舉例表示,他們共同研發了一套用于識別圖像的智能系統。當研究者將一張呈條狀波浪形分布、主體為黃綠兩種顏色的圖片交給這套系統識別時,他們發現,這套識別系統用99.6%的確定性,將這張“毫無主題的水彩畫”認作了“海星”;而在面對另一張布滿雜亂混合斑點的圖片時,該AI系統再一次犯錯——它將圖示當中的主體推論為“豹”,并對真實性做出了接近于100%的保證。

很顯然,“小狗實驗”和克魯主導的圖像識別實驗,都向人們反映出了這樣一個現象——人工智能在進行分析推理的過程當中,也會受到來自模型缺陷的干擾。比如在克魯的實驗當中,研究人員設定的識別模型,在樣本定義上必然是存在不足的。對此,另一位人工智能學者、來自普林斯頓大學的索倫·巴洛卡斯就認為,克魯的模型當中沒有設定“生命”和“非生命”的限定,這就使得人工智能無法對一個樣本進行有效區分。

圖 克魯實驗:系統將左圖識別為海星,右圖識別為豹

巴洛卡斯解釋說:“就以那張布滿雜亂斑點的圖像來說,假如克魯團隊關于識別模型的設定限定了‘很多斑點=豹’這一規則,那么當人們將這張圖片錄入到該模型當中時,這個識別系統就會因為從圖片上檢測出很多斑點,進而做出‘此圖示為豹’的結論。”

可以看到,人工智能的邏輯推理是帶有強烈的程式化意味的。由于既定模型的局限性,即便是性能最為優越的AI系統也會在判定時出現偏差。而在生活當中,這一種推理機制帶來的缺陷,也很可能會為人們帶來極大的不便或者其他隱患。比如說在反入侵智能識別系統當中,一些不懷好意的人就可以通過識別模型的漏洞,給自己偽裝上適配于該模型的裝置,然后就可以順利通過智能機關的檢驗。所以說,如何利用規則,回避類似漏洞就成了研究者們需要重點關注的話題。

顯然,在巴洛卡斯的話語當中,我們已經能剝離出部分解決人工智能因何被騙的誘導因素了。按照他的說法,AI系統之所以能針對未知事物進行判定推論,內置在這一系統中的神經網絡起到了關鍵性作用。而一旦這個網絡出現部分可被利用的漏洞,那么當有“非正確的適應性樣本”進入檢驗階段時,這個錯誤的樣本就會被接受并解讀出來。

比如說對于某一個神經識別網絡,我們設定以下規則:

(1)穿紅色衣服的學生每人得到1個蘋果

(2)穿黃色衣服的學生每人得到2個蘋果

(3)穿非紅色衣服的學生不分配蘋果

很顯然,第三條規則的介入,對整個評判體系產生了錯誤的影響。對于1名穿黃色衣服的同學來說,如果按照第二條規則來執行分配,他就會得到2個蘋果;如果按照第三條規則來界定,他就被排除在了分配原則之外。而在一個神經網絡中,類似沒有受到加權限制的規則,很可能會同時執行,那么使用這一種網絡模型來分配蘋果,必然會出現一部分黃衣服學生持2個蘋果,另一部分黃衣服學生沒有分到蘋果的混亂現象。

所以說,在一個模型體系中,互相之間存在矛盾的因素,是會對這個模型帶來極大的負面效果的。針對這種情況,其實只要再加上一條“假如規則之間發生沖突,以規則(1)為準”,這一切就迎刃而解了。

另外,在上述幾條規則當中,同樣也存在沒有針對樣本進行深入限定的問題。比如有1名穿紅衣服的玩偶混雜在了待分配者中,那么AI系統也會按照既定條例,給這個玩偶發放1個蘋果。那么針對這一漏洞,設計者需要做的其實和之前一樣,那就是增設規則選項,將受分配者限定為“能夠呼吸的人類”。

所以說,人工智能受到欺騙,實際上更多因素是受制于內置模型的缺陷。由于對樣本規則的限定缺漏,人工智能在推理的過程中也會受到各種誤導。由于識別系統的模式化,AI系統對于樣本的判定都是通過模型當中的設定點來尋求對應關系的,在這種條件下,部分不符合要求的結果,或許也能因為關鍵點的契合而順利通過。如果要解決這一問題,設計者就需要研發出更為精準、驗證節點更多,或者是研發出以“線性”“面性”,甚至是“立體性”的驗證規則,而這就需要研究者進行更為深入的研究。

京公網安備 11010502049343號

京公網安備 11010502049343號