上世紀的“廣告教父”大衛·奧格威在世時一直營銷著一個概念:“在現代商業世界,如果你不能將所創造的東西賣出去,只成為一個富有創意的思想家是毫無用處的。”

回顧歷史上的每一次變遷,從學術創意到切實部署的軌跡勾勒出進步的藍圖,有如從概念到商業化的過程。隨著 GPT 等大模型技術的高速成長和普及,模型的開源資源、部署訓練架構、算力成本成為大模型應用落地和企業盈虧 ROI 的關鍵分水嶺,重要性不低于模型精度。

繼今年 3 月的首屆 NPCon 大會探討了 ChatGPT 對技術社區的影響之后,8 月 12 日,CSDN、《新程序員》聯合主辦的“新程序員大會(NPCon):AI 模型技術與應用峰會” 于北京格蘭云天大酒店再度揭幕。

本次峰會主題圍繞「全鏈路搭建 AI 研發底座」展開,是 CSDN 今年推出的“AI 主題季”系列活動之一。峰會活動分別會在北京、上海、深圳、成都四城舉行,北京站現場邀請到千芯科技董事長陳巍,Dify.AI 創始人張路宇,美團基礎研發平臺視覺智能部軟件開發工程師張旭,浪潮信息人工智能與高性能應用軟件部 AI 架構師Owen Zhu,CSDN 研發副總監梁灝,圍繞算力資源運維、模型訓練部署、AI 能力構建等方面,為不同規模階段的企業、團隊、個人開發者,提供如何構建 AI 基礎設施、實現工程落地,提供全鏈路的建議和方案。

以下是本次“AI 模型技術與應用峰會”的演講精華。

部署就是大模型的成敗關鍵

首先,知乎科技領域答主@陳巍談芯、千芯科技董事長、人工智能算法-芯片協同設計專家陳巍帶來了分享《大模型涌現,如何部署訓練架構與算力芯片》。他的核心觀點在于強調大模型訓練和部署過程中的技術優化、隱私保護、成本效益以及未來芯片發展的重要性。

知乎科技領域答主@陳巍談芯、千芯科技董事長 陳巍

陳巍指出,大模型的本質是對知識的壓縮和對輸入的反饋,一個常見大模型的生存周期分為模型的計劃、高質量數據的收集、模型的建模和部署三個階段。其中,部署是大模型成敗和能否盈利的關鍵。

他認為,在大模型訓練和部署中,使用并行化技術(如數據并行、模型并行、張量并行)可以充分利用計算資源,提高效率。他強調通過優化通信,減少數據傳輸冗余,可以降低計算芯片之間的通信成本,從而提升整體訓練效率。

陳巍關注大模型部署中的隱私問題,特別是個性化數據和敏感信息的保護。他介紹了隱私保護技術,如將個人數據合并以降低隱私風險,并限制模型輸出中的敏感信息。陳巍強調,對于涉及個人隱私和敏感信息的部署,必須采取適當的隱私保護措施。

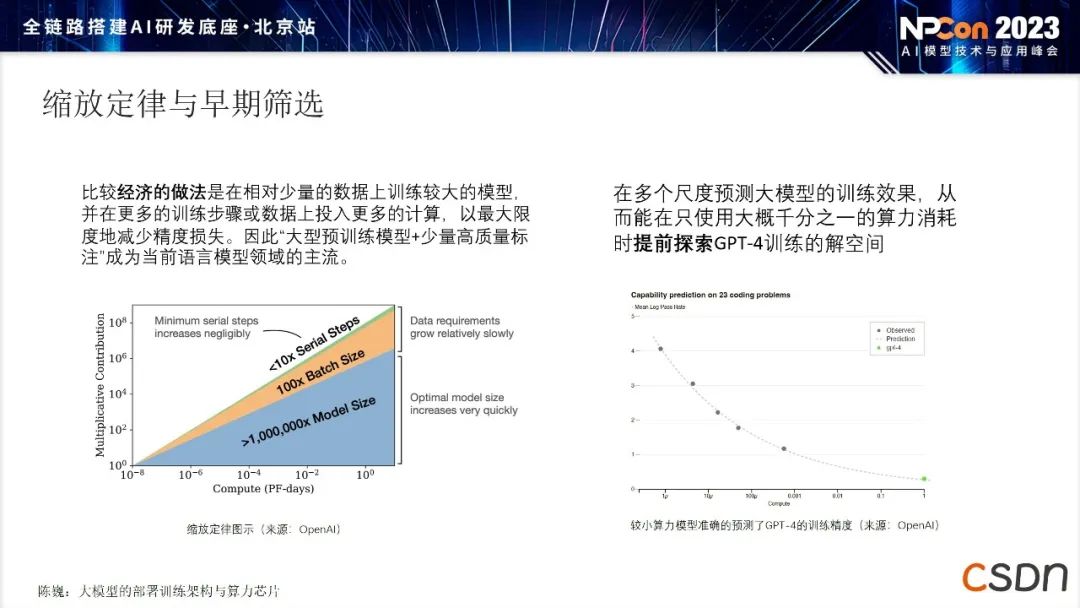

此外,陳巍提出了不同的方法來降低大模型訓練和部署的成本。他介紹了模型訓練成本的評估方法,包括如何通過數據大小和訓練條件來優化成本。他還探討了不同算力芯片(CPU、GPU、DSA、TPU)的應用,以及如何通過合理的策略來降低成本。

最后,陳巍強調未來芯片的發展可能對大模型訓練和部署產生影響,特別是在現有 GPU 生態受到限制的情況下。他認為在不同的算力芯片中,TPU 和 DSA 可能逐漸代替傳統的 GPU 應用。陳巍呼吁采取合適的技術策略和隱私保護措施,以降低成本、提高效率,并關注未來芯片趨勢對于人工智能產業的影響。

Agent 是大模型未來

最有想象力、最有前景的方向

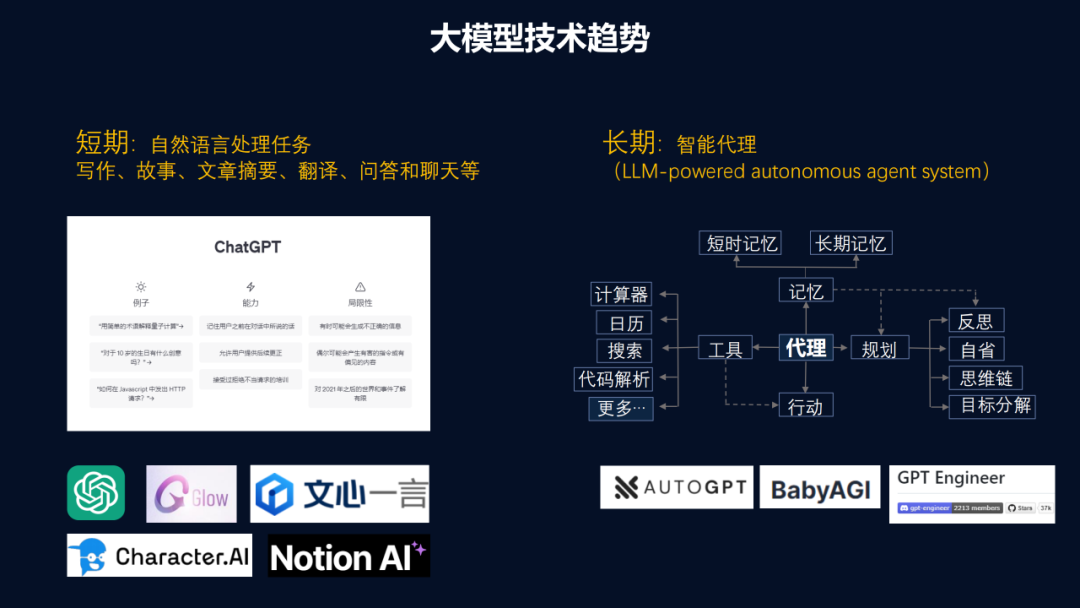

“Agent 是 LLM(大語言模型)的最有前景的方向。一旦技術成熟,短則幾個月,長則更久,它可能就會創造出超級個體。這解釋了我們為何對開源模型和 Agent 興奮,即便投產性不高,但是我們能想象自己有了 Agent 之后就可以沒日沒夜地以百倍效率做現在手上的工作。未來可能會有 Agent 網絡,每家公司甚至每個人都有自己的Agent,互相調用形成網絡效應,帶來繁榮的生態。”,Dify.AI 創始人張路宇在主題演講中如是說道。

Dify.AI 創始人& CEO 張路宇

張路宇指出,開發者在應用大模型時常常面臨向量數據庫、Agent編排等問題,并且許多開發者在初期都需要解決相似的難題,導致效率低下。盡管有大量應用和模型,實際投產的應用比例只有 5% 左右。

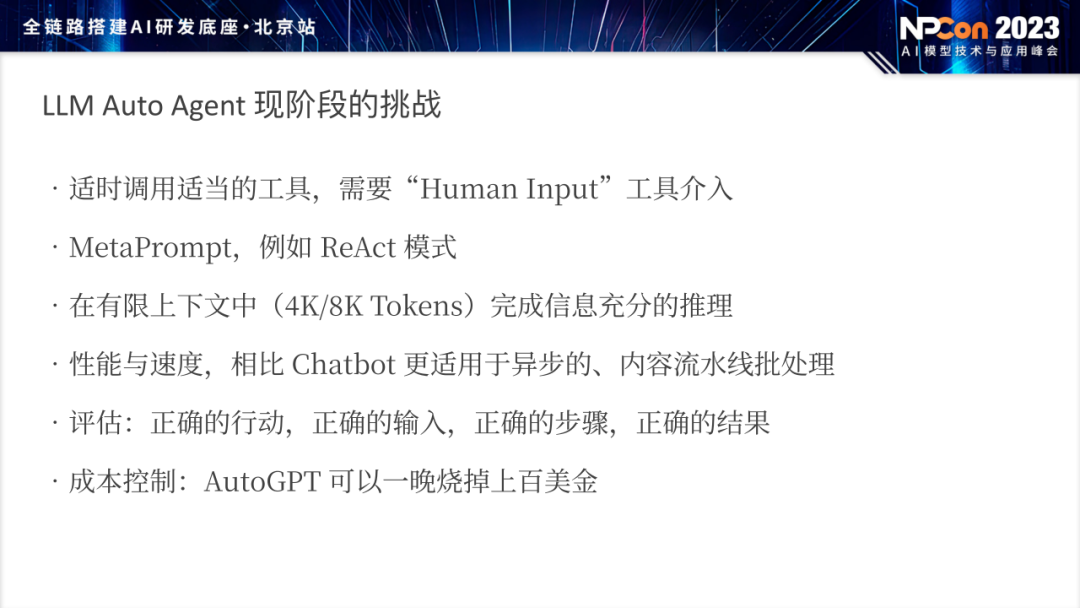

由此,張路宇強調了自動代理(Auto Agent)在推理模型、編程范式和應用構建方面的重要性和挑戰。他提出了“規劃、記憶、工具的使用和總結與反思”這四個關鍵要素來解釋自動代理的推理過程。他強調了規劃過程的重要性,將任務分解為多個步驟,并介紹了長期記憶和短期記憶的概念,探討如何適時調用工具、合理使用人類輸入、進行多輪對話,并強調推理性能、透明性和成本控制等方面的挑戰。

張路宇提到 LangChain 作為一個學習大模型應用開發的教科書,提供了抽象概念和工具。但他也指出了 LangChain 的局限性,特別是在工具和集成鍵方面的脆弱性,以及不適合非技術人員的參與。他說道:“每個人都要學習 LangChain,但最終都會丟掉它。”

演講中,張路宇引入了 MetaPrompt 的概念,將其描述為一種結構化的提示方式,可引導模型進行復雜的推理和行動。他指出,MetaPrompt 是引導大模型執行任務的關鍵工具,將用戶問題、前期反思、工具調用和模式以特定格式描述成提示。

張路宇認為,面對大模型的開發,傳統的編程范式已經不再適用。他提出了一種新的編程范式,即 "prompt first"。在大模型應用開發中,傳統的需求分析和 API 文檔設計可能不再適用。相反,他強調在設計應用之前應先考慮模型的輸入提示(prompt),并用這種方式引導模型執行任務。

如何高效推理,

仍是大模型時代亟需解決的挑戰

緊接著,美團基礎研發平臺視覺智能部軟件開發工程師張旭在發表《美團視覺 GPU 推理服務部署架構優化的實踐》主題演講中表示,GPU 利用率低的問題正日益凸顯,其核心癥結在于模型服務存在性能瓶頸。通過拆分微服務、優化部署架構以及綜合考慮多個優化層面,將模型 CPU 和 GPU 運算部分解耦,能實現模型部署工程的性能優化,讓服務性能成倍提升。

美團基礎研發平臺視覺智能部軟件開發工程師 張旭

隨著技術應用在線服務推理資源不斷增加,GPU 推理資源的使用比例逐年上升,但 GPU 的利用率卻一直在被浪費。張旭透露,業界的真實 GPU 利用率哪怕樂觀估計也只有 20% 左右。造成服務 GPU 利用率低下的重要原因之一是模型服務本身存在性能瓶頸,在極限壓力情況下也無法充分利用 GPU 資源。

乍一看,模型部署十分完善,事實上,當前的模型優化不徹底,部分算子無法優化加速,多模型的串聯部署也很困難。在 GPU 異構計算體系下,模型中 CPU 和 GPU 運算之間還存在相互影響的問題。張旭指出,這種影響會導致 CPU 和 GPU 無法同時充分利用,從而降低了推理服務的整體性能。

為此,張旭提出了解決 CPU/GPU 互相影響問題的一種優化方法,即將模型中的 CPU 和 GPU 運算部分分別拆分為獨立的微服務。他通過實際案例演示,將預處理和后處理部分獨立到通用 CPU 服務,主干網絡部分部署在 GPU 上,從而實現了更高的 GPU 利用率和整體性能提升。

在復雜視覺場景下,多模型的組合會引發更嚴重的 GPU/CPU 影響問題。張旭通過實例說明了針對多模型組合的場景,同樣可以采用 CPU/GPU 拆分部署的方式,將不同模型部分分別部署,以解決性能瓶頸問題。他強調不同優化層面之間的相互影響和迭代優化的重要性,以實現性能的持續提升。

算力是驅動大模型創新和進步的基石

在現代人工智能領域,算力扮演著推動創新、實現突破的核心驅動力。浪潮信息人工智能與高性能應用軟件部 AI 架構師Owen以《AI 大模型算力系統分析》為主題,強調了算力、算法、數據和系統架構等多個方面的綜合優化對于大規模模型訓練的成功至關重要。

浪潮信息人工智能與高性能應用軟件部 AI 架構師 Owen

浪潮信息早在2020年就開始布局和投入AI大模型技術的研發,Owen從“源”大模型的研發歷程切入,講解了大模型研發過程中的數據、算力和算法等各方面的挑戰。并指出國內企業在上半年對算力的需求增加,尤其在大型模型訓練方面。他強調了 GPT-3 和 GPT-4 等模型的重要性,同時提到了中國企業在這一領域的競爭和發展前景。強調了算力投入是評估模型能力一個重要指標。

隨后,Owen探討了大模型研發過程中預訓練、微調和模型推理等環節的核心關鍵因素和主要計算特征。并強調,未來大模型的產業化發展是一套復雜的系統工程,構建高效穩定的算力平臺是核心要義,成熟的算法、數據產業鏈,配套工具鏈及豐富的生態鏈是關鍵因素,我們亟需以系統的方式尋找最優解。

用好工具,人人都是 AI 應用開發者

在閃電演講環節,CSDN 研發副總監梁灝先是介紹了自己的經歷:將開源 iView 從 0 做到 20,000 Star,最大的感受便是好的工具能讓開發更簡單。而他要介紹的 InsCode,正是這樣的平臺。

CSDN 研發副總監 梁灝

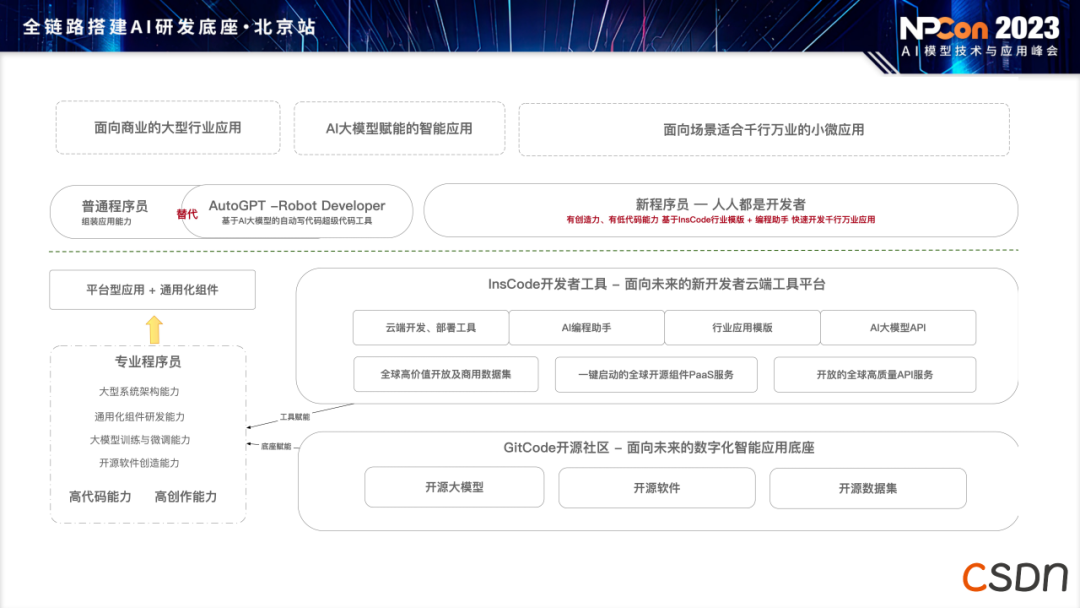

InsCode 是 CSDN 于 2023 年推出的一站式應用開發工具和服務平臺。它在瀏覽器中實現從編碼到部署的完整過程。僅僅在四個多月內,InsCode 就吸引了超過 5 萬注冊用戶,其中一半以上為開發用戶。累計創建了 4 萬多個項目,其中許多項目已經公開發布或部署到社區。梁灝指出,InsCode 徹底改變了傳統的開發流程,使用戶能夠在線上完成應用的開發、部署、運維和運營,從而使應用開發變得更加簡單。

梁灝強調了 InsCode 在 AI 時代的地位,尤其是其面向開發者的 AI 服務。他提到,專業程序員可以借助 InsCode 提高開發效率和創造能力,普通程序員可以通過生成式 AI 工具減輕編碼工作,而泛開發者甚至可以利用模板和自然語言提交需求,快速開發多樣化的應用。正如 CSDN 的 Slogan:人人都是開發者。

最后,InsCode 聯合創新工場盛大召開 AI 應用編程大賽,目前活動已處于啟動階段,歡迎讀者們訪問 inscode.net 進行報名或者參賽,贏取豐厚獎金。

開談:AI 時代的研發新范式

與開發者能力演進

在本次論壇的《開談》環節,由 CSDN 人工智能技術編輯團隊主持,華為諾亞方舟實驗室技術專家董振華,投研機構 INP(Infra Native Partners)創始人丁寧,CodeGeeX 團隊算法專家沈磊,聆心智能創始人& CTO 鄭叔亮作為嘉賓的圓桌對話正式展開。

本次《開談》的主題為“AI 時代的研發新范式與開發者能力演進”,五位技術專家聚焦于過去一年內 AI 技術和模型的快速發展,特別是大模型的涌現以及與模型開發相關的基礎設施和應用技術的突破,探討大模型的未來走向,未來編程語言和開發范式的影響,以及如何通過工具提高效率、學習 AI 知識和技能并在競爭激烈的領域中保持競爭力。

”模型團隊應該更關注模型效果,也要努力做具體應用。擴大模型參數量至兩倍所產生的效果,遠高于對其做加倍預訓練所呈現的效果。夯實大模型 L0 層能力、對行業模型進行優化是我們的努力方向。”,華為諾亞方舟實驗室技術專家董振華分享道。

董振華是研究者,也是《新程序員》的忠實讀者。他從研究者的角度強調開源在追趕人工智能技術方面的重要作用,認為開源可以幫助解決人工智能技術以及大模型的問題,使其更好地落地和應用。未來,不同規模階段的企業、團隊和開發者都應該擁抱開源,將先進的技術借鑒于開源社區,從而形成更有條理的發展模式,不僅僅是商業公司的行為。

華為諾亞方舟實驗室技術專家 董振華

當談及大模型生態的問題時,投研機構 INP(InfraNative Partners)創始人丁寧回答:“大模型生態從商業考慮,相比面向具體任務做模型 Finetune,要更關注其通用能力;與過去模型參數內僅是特征提取器不同,現在還包含意識形態、價值觀等要素給大模型生態商業化帶來更多不確定性。”

丁寧從不同類型的創業公司角度,分析了商業應用與研究階段的優先級問題。他將創業公司分為幾類,包括做 Foundation Model 的、做 Fine-Tuning 的以及使用平臺集成的。丁寧認為,在 Foundation Model 階段,重點在于搭建可擴展的算力集群、高性能網絡以及高性能數據存儲基礎設施,設計精巧的逼近實驗以求盡可能高的提高單次模型訓練ROI,力求用最小的成本換取最大的實驗進展。

在Fine-Tuning階段,重點在于如何將大語言模型應用于特定領域,并解決訓練和數據管理等基礎設施問題,但更重要的是建立數據的內循環與業務的外循環。如果不去接觸模型訓練,他強調了應用工具和服務的重要性,如何將大語言模型與現有技術結合,提供工具的同時也要提供持續的服務,例如合規、安全監控、線上業務持續性保障等實際應用價值。

投研機構 INP(Infra Native Partners)創始人 丁寧

CodeGeeX 團隊算法專家沈磊則強調了在使用大模型方面的實踐建議和團隊協作的重要性:“我的建議是要擁抱新的工具和功能。對于個人開發者或者公司來說,使用輔助工具可以顯著提升編程效率,甚至提高 10% 的效率對于一個人來說也是很可觀的進步。當我們面對變化時,要勇于接受并嘗試新的技能和工具,這將對個人和團隊都非常有幫助。”

沈磊為想要使用大模型的公司或個人給出建議,首先嘗試使用開源的模型和插件。這可以幫助他們在實際場景中試用模型和微調代碼,了解模型效果,從而在做出關于使用什么樣的模型、框架和機器配置的決定時更具有理性和經驗。

CodeGeeX 團隊算法專家 沈磊

在開源領域的話題上,聆心智能創始人& CTO 鄭叔亮闡釋了自己的觀點:“開源模型讓創業者借助大平臺搭建原型、實現核心創新突破并快速交付產品,制造多贏的局面。但初創公司仍需厘清其中存在的安全性和價值觀風險,才能在開源的土壤生根發芽。”

對于未來可能會創造的機遇,鄭叔亮表示:“在我們上學的時候,編譯原理課程需要花兩個學期來完成一個編譯器,數據庫課程則要求編寫一個 DBMS 系統,本科階段的大作業基本都是這樣的。這種經歷讓我們在面對新技術時更加從容,不會對挑戰、威脅或恐慌過于擔憂,而是欣然接受新鮮事物。簡而言之,如果我們不能成為創造浪潮的人,至少應該成為在浪潮上跳舞的人。雖然只有少數人會創造這波浪潮,但更多的人可以站在潮頭,享受其中的樂趣。”

聆心智能創始人& CTO 鄭叔亮

大模型時代的新程序員

NPCon 中的“NP”是“New Programmer”(新程序員)的縮寫,它承載著兩重含義。首先,它象征著《新程序員》雜志,這是 CSDN 延續近 20 年的《程序員》雜志的全新篇章。其次,它象征著我們站在人工智能紀元的起點,或許將親歷程序員職業范式的巨變,成為新一代的程序員。

CSDN 這些年一直在持續關注人工智能技術這一賽道,與其他以 AI 為主題的垂直媒體不同的是,CSDN 擁有近五千萬開發者社區規模的平臺,除了關注科研突破和商業應用外,更著重關心人工智能應用的工程實現。當前,人工智能技術不斷刷新能力極限,各種相關新聞層出不窮,然而實際情況是,我們在基礎設施、工程實施、成本以及應用落地方面依然面臨著漫長的前行之路。

不論我們是創新的推動者還是變革的見證者,我們都應該邁出那一步,踏上旅程。若“新程序員”不能成為浪潮的奠基者,至少應當成為其中的弄潮兒。新程序員們會懷揣著創業的精神,始終保持持續學習的狀態。如此一來,我們的努力才會更具深遠的意義。

與此同時,CSDN 也將持續更新 AIGC 和大模型技術的發展動態,為廣大技術愛好者提供最新的技術資訊和最優質的學習資源與工具,成就更多技術人與開發者,歡迎關注。

京公網安備 11010502049343號

京公網安備 11010502049343號