實際應用中,大數據存儲解決方案一般有存算融合和存算分離兩種部署形態。存算融合以基于服務器的超融合系統為代表,它將服務器的計算、存儲、網絡等資源進行統一管理和調度,具有彈性的橫向擴展能力;但是當實際業務對計算和存儲需求不同時,該方案存在資源擴展不靈活、利用率低下等問題。存算分離將存儲資源和計算資源拆分為獨立的模塊進行建設,在資源利用率、存儲資源高效共享、多場景靈活部署、網存算協同等方面具有顯著優勢。存算分離架構當前已經在許多場景得到應用:金融及電信等行業核心交易系統、數據庫等關鍵應用通常采用小型機結合高端存儲的方式;在企業辦公場景下,為滿足跨平臺企業應用的數據共享訴求,通常采用通用服務器結合文件共享存儲(Network Attached Storage,NAS)的方式;在大數據場景下,為實現多業務數據共享,通常采用分析計算服務結合數據湖的形式。多樣化的存算分離實踐為存儲系統帶來了數據共享、靈活伸縮等優勢。

存算分離技術發展分析

新的業務挑戰

從云和互聯網的業務場景來看,其存儲域主要采用基于服務器部署分布式存儲服務的融合方式,它面臨如下挑戰:

1.數據保存周期與服務器更新周期不匹配。大數據、人工智能等新興業務催生出海量數據,大量數據需按照其生命周期策略(例如8~10年)進行保存。而在當前存儲域中,基于服務器的存儲系統換代周期由處理器的升級周期(例如3~5年)[1]決定。這種數據生命周期與服務器更新周期之間巨大的差異導致系統資源被大量浪費,比如,存儲域中服務器組件都隨CPU升級而淘汰,為此須進行相應的數據遷移等[2]。

2.性能可靠與資源利用率難以兼得。支撐業務的分布式存儲系統大致可以分為性能型存儲和容量型存儲,它們均無法同時實現高性能可靠與高資源利用率。具體地,性能型存儲主要運行數據庫、虛擬化等關鍵業務,通常采用三副本或兩副本并配合獨立冗余磁盤陣列(Redundant Array of Independent Disks,RAID)卡模式;這類方案雖兼顧了性能和可靠性,但其大約30%的空間利用率卻是對存儲資源的極大浪費。容量型系統為了提升空間利用率,采用糾刪碼(Erasure Code,EC)方式,然而,EC計算過程中的讀寫、重構等會消耗大量網絡資源,導致系統重構效率低下、重構時間長,給系統可靠性帶來風險(如圖1所示)。

圖1 分布式存儲資源利用率

3.新型分布式應用的極簡高效共享存儲訴求。以無服務器(serverless)應用為代表的新型分布式應用在近些年涌現,這類應用從無狀態化向有狀態化擴展,比如數據庫、消息總線等組件紛紛容器化,數據共享訪問的訴求不斷增多。與此同時,人工智能和機器學習等應用需要大量異構算力協同,甚至產生共享內存訪問的訴求,它們關注高帶寬、低時延的訪問能力,僅需要輕量、便捷的共享存儲系統即可,不需要搭載具有復雜企業特性的傳統存儲。

4.數據中心稅導致數據密集型應用效率低下。面向數據密集型場景,在基于以CPU為中心的服務器架構下,應用為獲取數據所繳納的“數據中心稅”(datacenter tax)日益加重。例如,服務器內的CPU為處理網絡及存儲IO請求,需要消耗高達30%的算力[3];此外,由于通用CPU并不擅長數據處理運算,導致其能效比低下。

傳統存算分離架構將算力資源和存儲資源(機械硬盤、固態硬盤等)分離至彼此獨立的計算域和存儲域,并通過以太網或專用存儲網絡(例如光纖通道)將二者互連,實現了存儲資源的靈活擴展和高效共享(如圖2左側所示);該架構主要為復雜的傳統企業特性設計,難以應對上述挑戰,為了讓云和互聯網存儲域服務兼顧資源利用率、可靠性、性能、效率等眾多訴求,亟須基于新型軟硬件技術構建新型存算分離架構。

硬件技術趨勢

面對數據中心在容量利用率、存力效率等方面的挑戰,近年來,專用數據處理器、新型網絡等技術快速發展,為數據中心基礎設施的重構提供了技術基礎。

首先,為取代服務器本地盤,很多廠商推出以太網閃存簇(Ethernet Bunch of Flash,EBOF)高性能盤框(例如,近期陸續發布的西數OpenFlex、Vast Data Ceres高性能盤框等)。這類盤框不再具有復雜企業特性,而是注重采用新型的數據訪問標準,比如支持NoF(NVM Express over Fabric)等接口,以提供高性能存儲實現對本地盤的替換。NoF協議由NVM Express(NVMe)標準組織在2016年發布,提供了NVMe命令到多種網絡傳輸協議的映射,使一臺計算機能夠訪問另一臺計算機的塊存儲設備。同時,一些研究機構進一步探索遠程內存池化技術,例如,韓國KAIST實驗室實現了基于FPGA的CXL(Compute Express Link)互連協議[4];CXL為英特爾于2019年3月在Interconnect Day 2019上推出的一種開放性互聯協議,能夠讓CPU與GPU、FPGA或其他加速器之間實現高速高效互聯,從而滿足高性能異構計算的要求。

其次,業界涌現出越來越多的數據處理單元(Data Processing Unit,DPU)和基礎設施處理單元(Infrastructure Processing Unit,IPU)專用芯片,在數據流處理路徑上取代通用處理器,提升算力能效比。同時,基于可編程交換機的網存協同也是研究熱點,例如在網數據緩存的NetCache[5]、KV-Direct[6],在網數據協調的NetLock[7]、Concordia[8]、SwitchTx[9],在網數據聚合的SwitchML[10]、NetEC[11],在網數據調度的FLAIR[12]、AlNiCo[13]等相關論文紛紛在主流會議期刊發表。

最后,數據訪問網絡標準也在持續增強,比如CXL協議新版本加強了內存池化方向的技術特性,同時吸收了Gen-Z[14](由AMD、ARM、HPE等公司發起定義的面向內存語義的技術)、OpenCAPI[15](Open Coherent Accelerator Processor Interface,最早由IBM提出的異構計算接口)等技術的成果,正逐步成為業界主流高速互聯標準。NVMe 2.0也在向著語義統一、Fabric統一和介質統一方向演進。

這些新型存儲、計算和網絡硬件為構建面向云和互聯網場景的新型存算分離架構帶來了諸多機遇,譬如使用DPU等專用芯片能夠打破傳統以CPU為中心的服務器架構,由此提升數據密集型應用的效率。

新型存算分離架構的特征

隨著遠程直接內存訪問(Remote Direct Memory Access,RDMA)、CXL、可編程網絡設備、高性能NVMe SSD、持久性內存等新型硬件技術的發展,需要構建新型存算分離架構,以確保云和互聯網存儲域服務能夠兼顧資源利用率、可靠性、性能、效率等眾多訴求。相較于傳統架構,新型存算分離架構最為顯著的區別在于:(1)更為徹底的存算解耦,該架構不再局限于將CPU和外存解耦,而是徹底打破各類存算硬件資源的邊界,將其組建為彼此獨立的硬件資源池(例如處理器池、內存池、機械硬盤(HDD)/固態硬盤(SSD)池等),從真正意義上實現各類硬件的獨立擴展及靈活共享;(2)更為細粒度的處理分工,即打破了傳統以通用CPU為中心的處理邏輯,使數據處理、聚合等原本CPU不擅長的任務被專用加速器、DPU等替代,從全局角度實現硬件資源的最優組合,進而提供極致的能效比(如圖2右側所示)。

圖2 傳統存算分離架構與新型存算分離架構對比

總結來說,新型存算分離架構具有如下特征:

1.無盤化的服務器。新型存算分離架構將服務器本地盤拉遠構成無盤化(diskless)服務器和遠端存儲池,同時還通過遠程內存池擴展本地內存,實現了真正意義上的存算解耦,可極大提升存儲資源利用率。業務使用時,可根據應用需求選擇配置不同性能、容量的虛擬盤及池化內存空間,這樣一方面可以避免由于不同服務器本地存儲空間利用率過低導致超配造成的浪費;另一方面,當服務器出現故障或者更新換代時,也不影響數據的保存,不需要額外的數據遷移。

2.多樣化的網絡協議。連接計算和存儲間的網絡協議從當前的IP或光纖通道(Fibre Channel,FC)協議擴展到CXL+NoF+IP協議組合。CXL協議使得網絡時延降低到亞微秒級別,有助于內存型介質的池化;NoF協議加速SSD池化;IP協議可滿足HDD等慢速介質訪問訴求。通過這幾類協議組合構建的高通量網絡,滿足了多種場景池化接入訴求。

3.專用化的數據處理器。數據存儲、訪問等操作不再由通用處理器負責,而是卸載到專用數據處理器。此外,特定的數據操作可由專用硬件加速器進行進一步加速,如糾刪碼、加密壓縮、網絡通信等。通過專用數據處理器,可以釋放通用處理器算力,用于服務更適合的場景,顯著提升系統整體能效比。

4.極高存力密度的存儲系統。分離式存儲系統(disaggregate storage)是新型架構的重要組件,作為持久化數據的底座,在存儲介質的集約化管理基礎上,結合芯片、介質的深度協同設計,整合當前系統、盤兩級的空間管理,通過大比例糾刪碼算法減少冗余資源開銷比例。此外,還可通過基于芯片加速的場景化數據縮減技術提供更多的數據可用空間。

面向云和互聯網場景的存算分離架構及關鍵技術

面向云和互聯網場景的存算分離架構

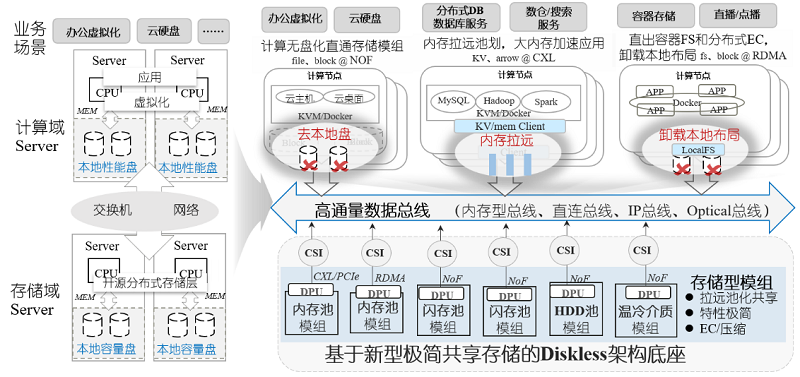

新型存算分離架構意在解決前文所提的當前架構面臨的幾大痛點挑戰,通過將原有架構的多級分層資源進行徹底解耦池化和重組整合,形成新的三大簡化分層:存儲模組、總線網絡和算力模組,從而提供服務器本地存儲拉遠池化、新型網絡靈活組裝、以數據為中心的多元處理、高容量極簡盤框等幾大新興能力。

存儲模組

面向云和互聯網數據中心,需要以更專業的存儲能力重新定義云和互聯網的存儲架構。新型存算分離架構中,存儲型模組主要以EBOF、以太網內存簇(Ethernet Bunch of Memory,EBOM)、以太網磁盤簇(Ethernet Bunch of Disk,EBOD)等新型盤框形態存在,RAID/EC/壓縮等傳統存儲能力下沉到新型盤框中,構成“盤即存儲”的大盤技術,對外通過NoF等高速共享網絡提供塊、文件等標準存儲服務。這一類新型盤框將傳統磁盤陣列的冗余池化技術和數據縮減技術進行了高度集約化和小型化。

從存儲模組內部架構來看,其介質層可由標準硬盤組成,也可由晶圓工藝直接整合的顆粒大板組成,盤與框的邊界融合有助于實現極致成本的創新。在介質層之上,存儲模組需構建類似傳統存儲陣列的池化子系統,基于RAID、EC等可靠冗余技術實現本地介質的池化,結合重刪壓縮等算法技術對數據容量進行大比例縮減,進一步實現可得容量的提升。為了支撐新型存算分離架構的高通量數據調度,存儲模組需要提供更加高效的數據吞吐能力,通常基于硬件直通等技術構建極簡的快速數據訪問路徑。和傳統陣列相比,存儲模組在IO處理上盡量避免用戶數據和控制數據(元數據等)的低效交織,盡量減少傳統存儲陣列的某些復雜特性處理(復制、雙活等容災特性),盡量減少子系統分層進而縮短IO處理的路徑,最終實現高吞吐、低時延的極致性能體驗。最后,通過硬盤亞健康管理,例如慢IO快速返回、慢盤隔離等能力,實現毫秒級穩定時延。

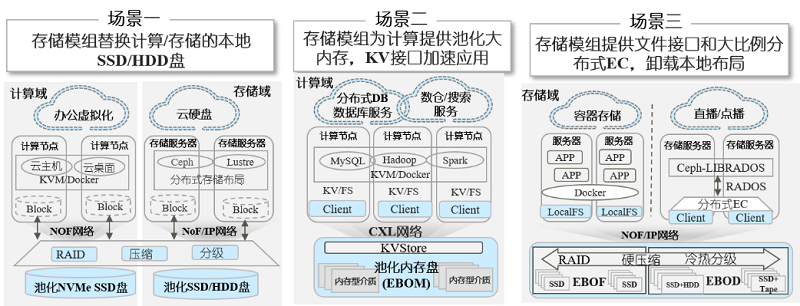

云和互聯網的多樣業務主要分為三種典型的應用場景(如圖3所示)。第一種場景是針對虛擬化業務,直接將數據中心存儲域服務器的本地盤拉遠,對分布式開源存儲集群的物理硬盤層形成替代。第二種場景是為數據庫、大數據服務等需要極熱數據處理的業務提供大內存、鍵-值(Key-Value,KV)接口,加速數據處理效率;第三種場景是針對容器等新業務場景,為Ceph、Lustre等分布式應用直接提供文件語義,卸載本地數據布局,并支持將溫熱數據分級到更冷的EBOD等機械硬盤或磁帶型存儲模組中,提升整系統資源使用效率。

圖3 存儲模組的三類典型應用場景

存儲模組作為一種存力集約化、緊湊化、極致化的新型存儲形態,加速了服務器的無盤化發展趨勢,將服務器的本地盤、內存等拉遠進行池化共享,有效支撐了傳統數據中心架構朝極簡分層的新型存算分離架構演進。

算力模組

當前,摩爾定律演進變緩,只有采用專用處理器才能進一步以異構方式發揮出下一階段的算力。引入專用處理器后,算力池化是必然選擇;否則,如果為每臺服務器配置異構算力卡,不僅使整機功耗巨大,還會導致資源利用率十分低下。以DPU為代表的專業數據處理器具備成本更低、功耗更低、即插即用、即換即用等獨特優勢,并且在運行狀態下不與業務應用發生資源爭搶,保證用戶業務正常運行的同時也保障了基礎設施的服務質量。

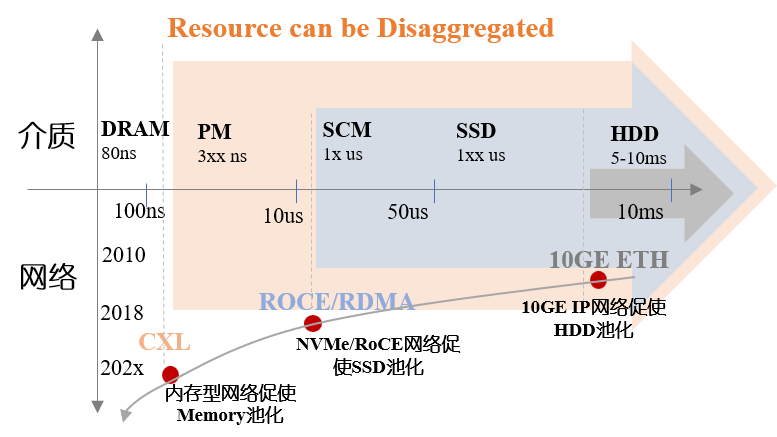

高通量數據總線

存算分離架構中,網絡技術非常重要,它決定了系統的響應速度以及吞吐能力,也決定了系統資源池化的能力范圍。過去10年,萬兆IP網絡促使HDD池化,基于IP網絡發展了支持塊、文件、對象共享的訪問協議。當前,面向熱數據處理,NVMe/RoCE(RDMA over Converged Ethernet,RDMA融合以太網 )促使SSD池化;并且,NVMe協議快速發展使其開始收編煙囪式協議規范。下一步,面向極熱數據處理,內存型網絡(例如CXL Fabric)將促使內存資源池化,為業務提供更大的共享內存空間(如圖4所示)。

圖4 網絡技術發展時間線

關鍵技術

新型存算分離架構改變了各類硬件資源的組合形式,其近遠關系、松緊耦合的變化催生了一系列圍繞該架構的關鍵技術,例如場景化數據縮減、高通量超融合網絡、網存協同、盤芯協同等。

場景化數據縮減

在新型存算分離架構下,數據縮減能力將下沉到存儲模組中,通過前后臺縮減任務配合,可有效減少對性能的影響,同時提升數據縮減率。此外,針對不同場景的數據特征,可使用不同的縮減技術。例如,針對基因、醫療等場景,可通過多幀圖片聚合壓縮、多波段數據合并壓縮等實現更高縮減率;在數據保護場景,可通過變長或相似性重刪獲得更高縮減率;在視頻、媒資場景,可通過前景提取、碼率控制等技術實現更高縮減率。

高通量超融合網絡

根據部署場景及多樣化網絡敏捷和自適應性的業務需求,存算模組間的網絡連接可以選用基于CXL Fabric、NoF、IP的組合進行組網,在網絡協議上,有以下關鍵技術需要考慮:

首先,網絡連接可以選用直連模式或是池化模式。直連模式下,網卡資源被設備獨占使用;池化模式下,網卡資源池化,被多個設備共享使用,可以提供更經濟的使用效率。池化模式下,需要解決網絡資源細粒度動態分配能力、安全隔離能力等,從而保證多個設備對資源的公平使用。

其次,跨機架通信通常采用RDMA機制。傳統RDMA連接數受限,需要解決大規模互聯的擴展性問題。例如,可使用無連接等技術,解耦連接狀態和網絡應用,做到支持數萬的連接規模;同時通過軟硬協同,硬件確保請求及時完成,提供快速的操作失敗通知,而軟件負責操作重試和故障恢復,兩者配合實現高性能可靠連接。此外,還可考慮使用多路徑技術,通過支持數據包亂序收發能力、異步ACK機制,解決單條網絡帶寬有限等問題。

網存協同

智能網卡和DPU是服務器的數據出入口,可編程交換機是服務器、存儲之間的數據交換中樞,它們在系統中占據特殊的位置。因此,結合其可編程能力,可以實現高效的數據協同處理。

首先,智能網卡和DPU可以實現任務卸載,包括NoF加速、壓縮及解壓加速、安全算法(AES、RSA、ECC、Diffie等)卸載、正則表達式卸載等;其次,利用其可編程能力,通過精細化的流水線并行技術,可將存儲的文件服務、塊服務、內存與KV服務等卸載到智能網卡和DPU里面,縮短IO訪問的響應時間;最后,面向特定場景加速(例如,虛擬化場景的虛機直通、大數據場景算子下推、shuffle協同等),可極大地提升系統運行效率。總之,充分利用好智能網卡和DPU的硬件加速資源,協同好主機和DPU間的任務調度,有助于降低主機數據處理開銷,提升IO訪問效率。

可編程交換機具備自定義網絡協議和網絡包轉發的能力,并且其上配置了小塊片上內存用于存儲數據,這些可編程能力結合交換機的中心化和高性能的優勢,可以實現在網數據處理加速。例如,將消息轉發和并發控制卸載至交換機,降低分布式協調開銷;或者,將元數據、熱點鍵值對緩存在交換機的內存中,并利用交換機中的算力執行相關插入、排序、查找、刪除等操作加速元數據響應。此外,還可利用交換機廣播、組播能力,實現數據副本傳輸,降低主機開銷。

盤芯協同

通過介質和控制芯片深度協同可獲得端到端最佳總體擁有成本(Total Cost Ownership,TCO)和效率。以數據冗余設計為例,原有的體系架構中存在多層數據冗余:即SSD盤內第一層的介質層EC冗余,在硬盤之上基于RAID或副本技術形成第二層冗余,每一層冗余設計相互獨立且無法協同。新型存儲型模組直接集成介質顆粒,僅在框這一級構建一層大比例EC的池化空間,輔助專有芯片對算法進行卸載加速,最終簡化了原有的多層冗余設計,有效改善端到端的資源利用率。

此外,還可基于專用芯片設計實現對磨損均衡、垃圾回收、多流等特定介質高級能力的深度管理,與上層應用協同垂直優化,實現場景優化。

最后,新型存儲模組基于專有芯片除了提供傳統IO接口外,還可以提供基于控制器內存緩沖區(Controller Memory Buffer,CMB)的旁路接口加速,這有助于系統元數據路徑繞開厚重的IO棧,使用遠程內存訪問方式來提升系統訪問并行能力。

面向云和互聯網場景的存算分離的技術挑戰與機遇

技術挑戰

面向云和互聯網場景的新型存算分離架構受網絡、算力等技術驅動,順應未來數據中心可組合式架構(composable infrastructure)趨勢。然而,構建這類系統并充分發揮其潛在效率,也面臨眾多技術挑戰,需要產業界、學術界專家共同探索解決。

首先,計算和存儲之間的數據訪問接口及標準主要采用“主-從”請求響應模式,并以傳輸塊存儲語義為主。然而,隨著內存盤、計算型盤、智能網卡異構算力的快速發展,內存訪問語義、計算協同存儲語義等方面的表現能力出現不足。此外,當前國內對于業界主流數據訪問接口的定義,如NVMe標準等,缺乏自主可控能力,實現我國自主定義存算間新型數據訪問標準意義十分重大。

其次,如何與已有生態應用結合,發揮出基于新型存算分離架構的基礎設施的潛力仍需深入探索。例如,新的數據處理器、全局共享存儲系統的引入,計算、存儲的獨立彈性擴展等,都為新型應用提供了較好的基礎設施能力,但如何最大限度地將這些基礎設施潛力發揮出來,如何設計更高效的應用服務框架,如何與上層應用協同等,都是一個長期而艱巨的任務。

機遇展望

根據我國“十四五”規劃,為助推社會經濟高質量發展、加強數字政府建設、激活數據要素潛能以及為各行各業的數字化轉型注入新動能,國家在多個地區構建智算中心,并基于一體化大數據中心構建東數西算工程。預計到2025年,我國將具備300 EFLOPS(Exa FLoating-point Operations Per Second)的算力,數據量將達到48.6 ZB[16]。這些規劃都為未來基礎設施的發展帶來極大的挑戰,例如,在如此高速度的算力增長下,如何避免因為存儲、網絡等性能限制導致算力長期處于空閑狀態?在介質產能有限的情況下,如何保存這些海量數據?此外,未來數據中心的發展將嚴重受限于其功耗預算和碳排放配額,如何提供綠色節能的基礎設施系統?這些問題既是挑戰,也是機會,相信新型存算分離以其靈活的架構、精細化的資源利用率、綠色低碳的能耗比等優勢,在我國宏大數字化歷史進程下,將迎來最佳的歷史發展機遇。

作者:舒繼武

舒繼武

CCF會士、信息存儲專委會主任。清華大學教授。廈門大學信息學院院長。主要研究方向為信息存儲系統、并行分布式系統、邊緣數據存儲系統等。

轉載自:中國計算機學會

京公網安備 11010502049343號

京公網安備 11010502049343號