ACL 是 NLP 領域學術影響力最高的國際會議,其誕生于人工智能技術發展的早期,至今已舉辦61屆。今年會議的研究議題覆蓋了大模型、機器翻譯、情感分析、對話和交互系統等26個領域,涌現了大量創新成果,阿里巴巴是歷年來論文收錄數量最多的機構之一。

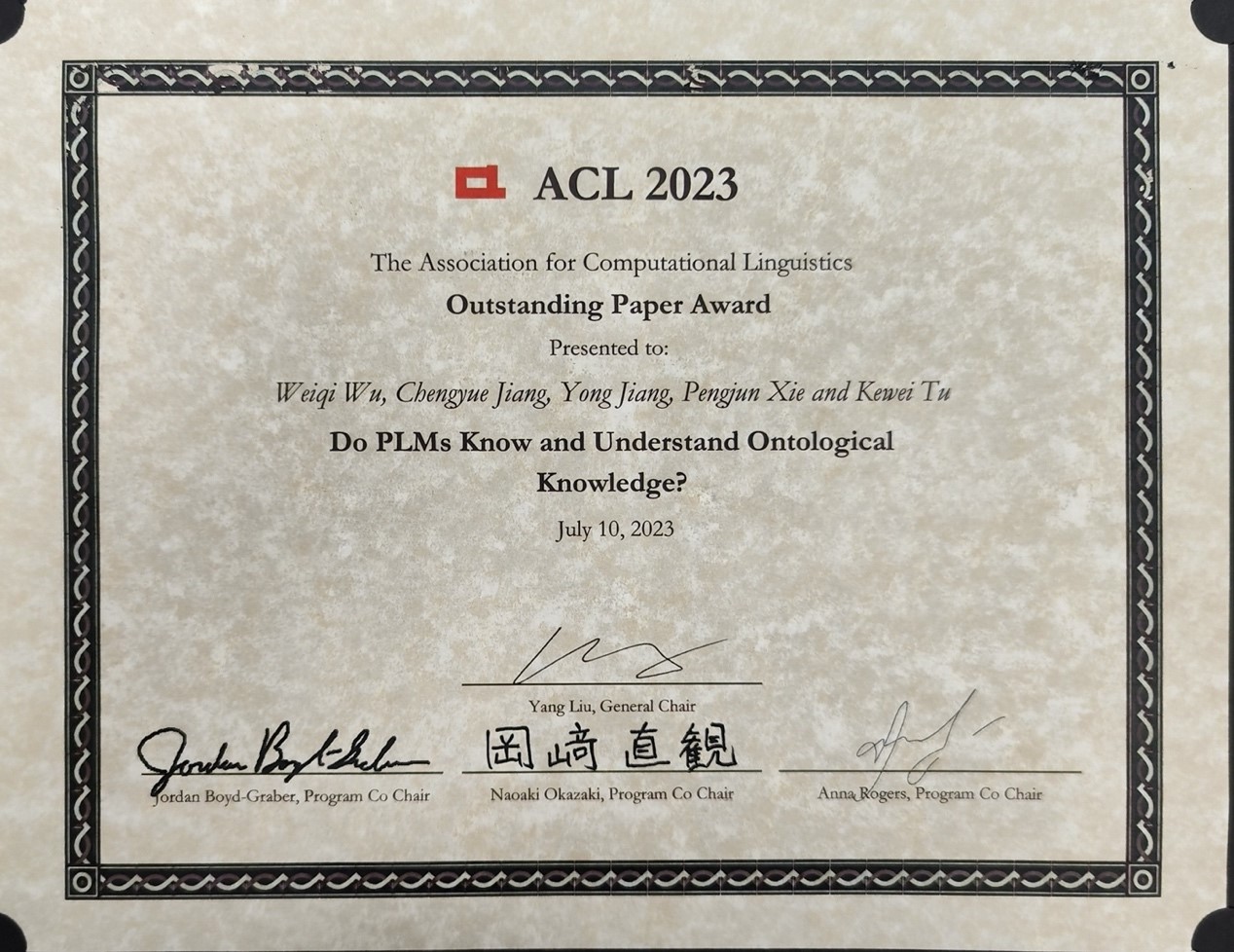

大模型是本次會議最熱門的研究領域,阿里達摩院的獲獎論文聚焦大模型的問題本質,針對大模型知識記憶和理解等知識幻覺相關問題提出了新的分析。研究團隊認為,盡管大模型將人工智能的智能水平提升了一個臺階,但當用戶提出知識型問題,大模型依舊會回復看似符合邏輯,但錯誤或并不存在的信息,該問題極大地制約了大模型的應用場景。

通過設計探針任務,該論文系統研究BERT、ChatGPT等預訓練大模型對本體類型知識 (實體、關系、類、屬性等)的記憶和理解程度,結果表明,預訓練大模型編碼了一定的本體性知識,并能利用記憶的知識進行推理,然而,當前大模型對本體知識的記憶和理解能力存在局限性。這為未來大模型的發展提供了新的方向。

該研究團隊表示,“大模型要進一步發展必須解決知識幻覺問題,幻覺是缺少知識的后果之一,我們需要持續分析模型對世界知識掌握的準確性,并找到該技術路徑的突破口,幫助業界對大模型有進一步的理解和認識,并有針對性的進行模型訓練。”

在ACL 2023同期舉行的全球規模最大的語義測評競賽SemEval上,阿里達摩院還蟬聯了唯一“最佳系統論文獎”。阿里達摩院聯合上海科技大學、浙江大學等提出了U-RaNER統一檢索增強方法,模仿人類從多源渠道查找知識并利用海量的新知識去更好地理解任務,以此來緩解預訓練模型本身知識不足的問題,該方法在知識密集型的多語言細粒度命名實體識別任務上的效果大幅度領先國內外團隊,在評測中取得9項冠軍。

京公網安備 11010502049343號

京公網安備 11010502049343號