Google曾在2016年11月16日宣布,將于2017年初通過其云端(Google Cloud Platform)的公共云發布圖形處理器(GPU)支持的虛擬機(VM)實例。

當時的市場背景是亞馬遜網絡服務(AWS),IBM SoftLayer和微軟Azure過去都推出了支持GPU的虛擬機實例。谷歌希望憑借其按分鐘而非小時計費的機制,和它提供的GPU多元化脫穎而出。用戶可選擇的GPU包括NVIDIA Tesla P100和Tesla K80,以及AMD FirePro S9300 x2。

而今天(2017年2月21日,InfoQ注),Google宣布,其云計算平臺推出了支持云端GPU加速服務的公開測試版,目前支持的GPU是NVDIA Tesla K80,憑借GPU超強的計算力,云端的性能獲得了大幅度的提升。

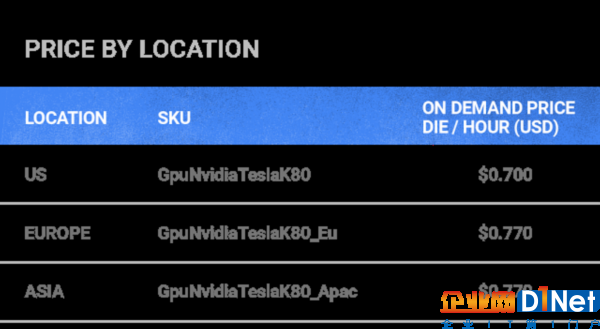

目前,用戶現在可以使用gcloud命令行工具在云平臺上的三個地區(us-east1、asia-east1和eurpo-west1)上創建基于NVIDIA GPU的虛擬機。

Google表示,下周他們將支持使用Cloud Console創建GPU虛擬機。

據在Google官網了解到的信息,如果用戶需要額外的計算能力進行深度學習,最多可以將8個GPU(4塊K80的板子)連接到自定義的Google Compute Engine虛擬機。GPU可以加速多種類型的計算分析,例如:視頻和圖像轉碼、地震分析、分子建模、基因組學、計算金融、模擬、高性能數據分析、計算化學、金融、流體動力學和可視化等等。

Google Compute Engine上的GPU是直接連接到虛擬機上的,提供了與裸機相同的性能。它不需要用戶在自己的數據中心構建GPU集群,只需添加GPU到Google的云中的虛擬機即可。用戶可以靈活地選擇1、2、4或8塊NVIDIA GPU來構建自己的服務器形態,從而使得服務器上的自定義虛擬機實例獲得最佳性能。

用戶可靈活構建服務器形態。

每塊NVIDIA K80配有2,496個流處理器、12GB的GDDR5內存。

據稱,這些實例支持流行的機器學習和深度學習的框架,如TensorFlow、Theano、Torch、MXNet和Caffe,以及NVIDIA流行的CUDA軟件(用于構建GPU加速應用)。

費用也是用戶很關心的問題。Google的云GPU很有競爭力,按分鐘(至少10分鐘)進行計費。在美國,連接到虛擬機的每個K80 GPU的價格為每小時0.70美元;在亞洲和歐洲,每個GPU每小時0.77美元。

用戶選擇Google云GPU的好處是,只需按使用的量支付費用,不需自己構建、維護一個GPU集群,就可以進行快速的深度學習和機器學習訓練,而這些都是零資本投資的結果。

Google云GPU集成了Google云機器學習(Google Cloud Machine Learning,簡寫Cloud ML),幫助用戶節省大規模使用TensorFlow框架訓練機器學習模型所需的時間。現在,用戶不需要花費幾天時間在單臺機器上用大量的圖像數據集訓練一個圖像分類器,就可以在云機器學習中使用多個GPU執行分布式訓練,大大縮短開發周期并快速迭代模型。

Google ML是一項托管服務,通過云計算工具(如Google Cloud Dataflow、Google BigQuery、Google Cloud Storage和Google Cloud Datalab)提供端到端培訓和預測工作流。

Google建議用戶先在小數據集上并訓練TensorFlow模型開始,然后啟動更大的云機器學習,用整個數據集訓練模型,以充分利用Google云GPU的規模和性能。有關Cloud ML的更多信息,請參閱《快速入門指南》并開始使用,查看《Using GPUs for Training Models in the Cloud》這篇文檔以深入了解Google云GPU。用戶還可以使用gcloud命令行來創建VM,并開始嘗試TensorFlow加速機器學習。

感謝冬雨對本文的審校。

京公網安備 11010502049343號

京公網安備 11010502049343號