大數(shù)據(jù)處理常用框架

大數(shù)據(jù)處理框架負責對系統(tǒng)中的數(shù)據(jù)進行計算,并且從大量的單一數(shù)據(jù)點中提取信息和觀點。大數(shù)據(jù)處理框架可以分為三類,批處理框架、流處理框架和混合處理框架。

Hadoop早已證明了自己

Hadoop早已證明了自己

批處理系統(tǒng)是最古老的處理系統(tǒng)之一,其主要適用于操作大容量靜態(tài)數(shù)據(jù)集,并在計算過程完成后返回結果,對于一些需要訪問全套記錄才能完成的計算工作較為合適。而Apache Hadoop則是一種專用于批處理的處理框架,是第一個在開源社區(qū)獲得極大認可的大數(shù)據(jù)框架,基于谷歌有關海量數(shù)據(jù)處理的多篇論文與經(jīng)驗,Hadoop重新實現(xiàn)了相關算法和組件堆棧,簡化了大規(guī)模批處理技術,提高了易用性。Apache Hadoop可以高效的處理對時間要求不高的大規(guī)模數(shù)據(jù)集。

流處理系統(tǒng)會對隨時進入系統(tǒng)的數(shù)據(jù)進行計算,其可以處理幾乎無限量的數(shù)據(jù),但同一時間只能處理一條或很少量數(shù)據(jù),不同記錄間只維持最小量的狀態(tài)。流處理框架Apache Storm是最常用的選擇,其側重于極低延遲,甚至可以達到近實時處理的工作負載。Apache Storm可處理海量的數(shù)據(jù),而且可以以更低的延遲提供結果,適用于對于延遲需求很高的流處理工作負載。

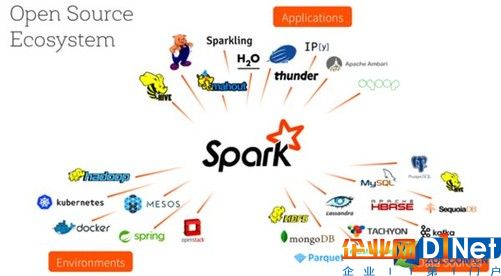

Spark正在證明自己

Spark正在證明自己

混合處理則是針對一些特殊處理框架同時解決批處理和流處理工作負載。這種框架可用相關的組件和API處理兩種類型的數(shù)據(jù)以實現(xiàn)簡化處理。Apache Spark最常見的一種的新一代批處理框架,Spark主要側重于通過完善的內(nèi)存計算和處理優(yōu)化機制加快批處理工作負載的運行速度,可作為獨立集群部署與Hadoop集成并取代MapReduce引擎。Spark是多樣化工作負載處理任務的最佳選擇,其批處理能力以高內(nèi)存占用為代價提供了速度優(yōu)勢。

大數(shù)據(jù)處理是讓數(shù)據(jù)被洞察和升值的過程,經(jīng)過了處理的數(shù)據(jù)才會閃現(xiàn)金子的光芒。

京公網(wǎng)安備 11010502049343號

京公網(wǎng)安備 11010502049343號