回溯到1968年,人們通過HAL9000對人工智能(AI)有了一些了解,HAL9000是一部主題為太空漫游的電影中的一臺有感知的計算機。HAL9000能夠實施語音和面部識別、自然語言處理、唇讀、藝術欣賞、解釋情感行為、自動推理,甚至可以下棋。

而在過去幾年,人們已經(jīng)確定人工智能成為日常生活中不可或缺的一部分。例如可以采用智能手機查詢旅行目的地的天氣情況,虛擬助理可以播放人們喜歡的音樂,人們的社交媒體帳戶將根據(jù)其個人喜好提供新聞更新和廣告。

但是在這些背景中發(fā)生了更多的事情,人們并不了解有助于促進健康甚至拯救生命、語言翻譯、新聞提要、面部識別、更加復雜疾病的準確診斷,以及加速藥物開發(fā)等企業(yè)開發(fā)和部署人工智能的一些應用。根據(jù)調研機構Gartner公司的預測,到2022年,人工智能衍生的商業(yè)價值預計將達到3.9萬億美元。

那么人工智能技術如何對數(shù)據(jù)中心產(chǎn)生影響?早在2014年,谷歌公司就在其中一個數(shù)據(jù)中心設施中部署了Deepmind AI(使用機器學習和人工智能的應用程序)。其結果是,能夠將數(shù)據(jù)中心用于冷卻的能源減少40%,這相當于在考慮到電氣損耗和其他非冷卻效率之后,PUE值減少了15%,這也產(chǎn)生了該數(shù)據(jù)中心有史以來最低的PUE。基于這些顯著的成本節(jié)省,谷歌公司希望在其他數(shù)據(jù)中心中部署該技術,并建議其他公司也這樣做。

Facebook公司秉承的使命是“讓人們有能力建立社區(qū),讓世界更緊密地聯(lián)系在一起”,F(xiàn)acebook公司的應用機器學習白皮書從數(shù)據(jù)中心基礎設施視角進行概述,它描述了支持全球范圍內機器學習的硬件和軟件基礎設施。

為了讓人們了解人工智能和機器學習需要多少計算能力,百度公司硅谷實驗室的首席科學家Andrew Ng表示,培訓百度的中文語音識別模型不僅需要4TB的訓練數(shù)據(jù),還需要20個計算機的exaflops計算量,也就是整個培訓周期內需要200億億次數(shù)學運算。

但是對于數(shù)據(jù)中心基礎設施呢?人工智能將如何影響企業(yè)希望構建、租賃或升級所有不同規(guī)模和類型的數(shù)據(jù)中心的設計和部署,以適應這種創(chuàng)新的、節(jié)約成本,甚至挽救生命的技術?

機器學習可以在一臺機器上運行,但由于數(shù)據(jù)量驚人,通常在多臺機器上運行,所有這些都相互關聯(lián),以確保在培訓和數(shù)據(jù)處理階段獲得持續(xù)通信、更低的延遲,絕對不能中斷的服務。人們對越來越多的數(shù)據(jù)的渴望推動了滿足需求帶寬量的指數(shù)增長。

這些帶寬需要使用更加復雜的架構設計,并在多個數(shù)據(jù)中心設施內部和跨多個設施進行分布,其中需要采用脊柱和葉脊網(wǎng)絡,而人們正在關注超級葉脊網(wǎng)絡,為所有復雜的算法提供在不同設備之間流動數(shù)據(jù)的高速公路,并最終回到受體。

數(shù)據(jù)中心的技術部署選項

這就是光纖在確保人們上傳圖片或視頻提供給全世界觀看、分享和評論方面發(fā)揮關鍵作用的地方。光纖已經(jīng)成為數(shù)據(jù)中心基礎設施的事實上的傳輸媒介,這要歸功于其高速和超高密度功能。隨著人們向更高的網(wǎng)絡速度遷移,還在混合部署中引入了全新的復雜性,也就是將采用哪種技術?

傳統(tǒng)的三層網(wǎng)絡使用核心、聚合和邊緣交換來連接數(shù)據(jù)中心內的不同服務器,其中服務器間流量通過活躍設備在南北方向上相互通信。然而現(xiàn)在,人工智能和機器學習可以帶來高計算要求和相互依賴性,更多的這些網(wǎng)絡是使用兩層脊柱和葉脊網(wǎng)絡實現(xiàn)的,其中服務器由于超低延遲需求通過生產(chǎn)和培訓網(wǎng)絡而在東西方向上相互通信。

自從2010年IEEE推出40G和100G網(wǎng)絡傳輸技術標準以來,已經(jīng)出現(xiàn)了許多競爭性的專有解決方案,這些解決方案讓那些不確定要遵循哪條路徑的用戶有些困惑,例如是否采用SR、多模、LR、單模等技術。40G和100G這兩種技術都使用一對光纖在兩個設備之間傳輸信號。無論人們使用哪種設備或在該設備中安裝哪個收發(fā)器,這都是通過兩根光纖進行的簡單數(shù)據(jù)交易。

但是IEEE批準了40G以及更快的網(wǎng)絡解決方案之后,其競爭對手之間改變了游戲規(guī)則。現(xiàn)在人們正在研究使用標準認可的或專有的、不可互操作的WDM技術的兩種光纖,以及使用8芯光纖(4根傳輸、4根接收)的并行光學器件的標準認可,或多源協(xié)議(MSA)和工程技術接收),或20芯光纖(10根傳輸,10根接收)。

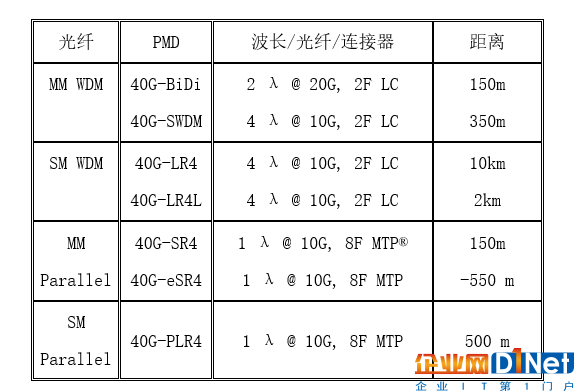

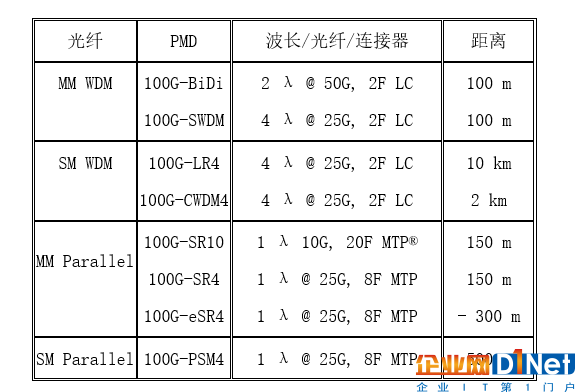

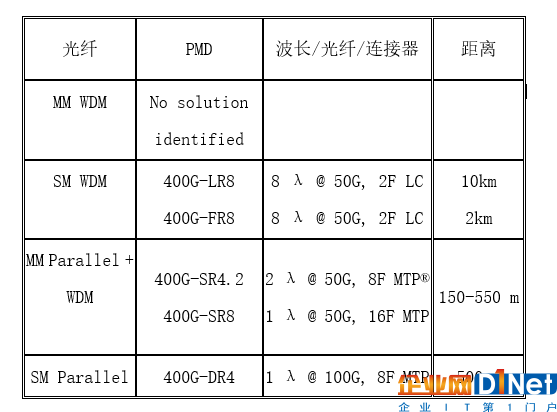

還有一些困惑嗎?那么請參閱下表,通常稱為不同物理介質相關(PMD)的字母表,它定義了物理層屬性,如介質類型、連接器類型和距離功能。

表1. 40G以太網(wǎng)

表2. 100G 以太表

表3. 400G以太網(wǎng)

因此現(xiàn)在已經(jīng)簡化了一切,以下進行簡單的總結。

如果企業(yè)希望繼續(xù)使用經(jīng)過標準認證的解決方案,并降低光學器件成本,因為企業(yè)不需要單模光纖的長距離功能,那么可以選擇多模并行光學器件,這樣就可以突破更加快速的40G或100G開關端口分為較小的10或25G服務器端口。

如果企業(yè)希望延長已安裝的雙工光纖的使用壽命,并且不介意與其首選硬件供應商保持聯(lián)系而不需要互操作性,并且不需要更長的距離,則可以選擇其中一種多模WDM解決方案。

大規(guī)模部署人工智能的大多數(shù)科技公司正在為當今和未來的網(wǎng)絡設計單模并行光纖解決方案。這有三個簡單的原因。

(1)成本和距離

目前的市場趨勢是首先開發(fā)和發(fā)布并行光纖解決方案,WDM解決方案緊隨其后,因此并行光學解決方案的數(shù)量要高得多,從而降低了制造成本。與2km和10km WDM解決方案相比,它們還支持更短的距離,因此企業(yè)不需要部署過多復雜的組件來冷卻激光器,并在兩端復用和解復用信號。雖然人們已經(jīng)看到這些“超大規(guī)模”數(shù)據(jù)中心設施的規(guī)模,但調查數(shù)據(jù)顯示,在這些設施中單模光纖的平均部署長度尚未超過165m,因此無需購買更昂貴的WDM收發(fā)器來驅動他們不需要支持的距離。

并行單模也比WDM解決方案使用更少的電能,正如之前從谷歌的例子中看到的電源使用情況,為了減少數(shù)據(jù)中心最大的運營成本,任何可以做的事情都是一件好事。

(2)靈活性

部署并行光學器件的主要優(yōu)勢之一是能夠采用高速交換機端口,例如40G,并將其分解為4×10G服務器端口。端口突破提供了巨大的規(guī)模經(jīng)濟,因為突破低速端口可以顯著減少電子設備的機箱或機架安裝單元的數(shù)量從3:1(并且數(shù)據(jù)中心資產(chǎn)并不便宜)并且使用更少的電能,需要更少的冷卻設施,并且可以進一步降低能源費用,調查數(shù)據(jù)表明這相當于單模解決方案節(jié)省了30%的成本。光纖收發(fā)器供應商還確認,所有銷售的并行光纖收發(fā)器中的很大一部分都是為了利用這種端口分支功能而部署的。

(3)簡單明晰的遷移

主要交換機和收發(fā)器供應商的技術路線圖為部署并行光學器件的客戶顯示了非常清晰和簡單的遷移路徑。而大多數(shù)科技公司都在遵循這條路線,所以當光學器件可用,并且從100G遷移到200或400G時,它們的光纖基礎設施仍然存在,無需升級。那些決定使用雙工雙光纖基礎設施的企業(yè)可能會發(fā)現(xiàn)自己希望升級到100G以上,但WDM光纖系統(tǒng)可能無法在其遷移計劃的時間范圍內提供。

對數(shù)據(jù)中心設計的影響

從網(wǎng)絡連接的角度來看,這些網(wǎng)絡是高度網(wǎng)狀的光纖基礎設施,以確保沒有一臺服務器相互之間有兩個以上的網(wǎng)絡躍點。但是這樣的帶寬需求甚至從脊柱交換機到葉脊交換機的傳統(tǒng)3:1超額配置比率還不夠,并且更典型地用于來自不同數(shù)據(jù)大廳之間的超級脊柱的分布式計算。

由于交換機I/O速度的顯著提高,網(wǎng)絡運營商正在努力提高利用率,提高效率,提供超低的延遲。

此外,在谷歌公司最近宣布推出最新的人工智能硬件之后,傳統(tǒng)的數(shù)據(jù)中心設計轉向了另一個轉變,這是一種名為Tensor Processing Unit(TPU 3.0)的定制專用集成電路(ASIC),在巨大的吊艙設計中,將其功能提高了8倍。但是,在芯片中加入更多的計算能力也會增加驅動它的能量,從而增加熱量,這就是為什么數(shù)據(jù)中心采用液體冷卻為芯片提供冷卻的原因,因為TPU 3.0芯片產(chǎn)生的熱量已經(jīng)超出了之前數(shù)據(jù)中心冷卻解決方案的限制。

結論

人工智能是下一波業(yè)務創(chuàng)新浪潮。它可以帶來運營成本節(jié)約,額外的收入流,簡化的客戶互動,以及更高效的數(shù)據(jù)驅動的工作方式,其具有很多優(yōu)勢。最近的一次小組討論證實了這一點,專家當時表示使用聊天機器人的網(wǎng)站如果效率不高且客戶關注度不夠,客戶就會放棄對話,并且很難再次合作。

因此,人們必須接受這項技術并將其用于其業(yè)務優(yōu)勢,這也意味著采用不同的方式思考數(shù)據(jù)中心的設計和實施。由于專用集成電路(ASIC)的性能顯著提高,人們最終會看到I/O速度的提高,甚至更深層次地推動網(wǎng)絡連接的發(fā)展。企業(yè)的數(shù)據(jù)中心需要超高效的高速光纖網(wǎng)絡、超低延遲、東西方向的脊柱和葉脊網(wǎng)絡,以適應企業(yè)日常生產(chǎn)流量,同時支持機器學習培訓。

人們已經(jīng)看到了主要的科技公司如何接受人工智能以及如何部署并行單工模式幫助他們實現(xiàn)比傳統(tǒng)雙工方法更高的資本和運營成本,傳統(tǒng)的雙工方式從一開始就承諾降低成本。但是隨著數(shù)據(jù)中心的運營以及繼續(xù)發(fā)展,專業(yè)人員的習慣和交流方式在不斷變化,提高了網(wǎng)絡速度,并增加了復雜性。現(xiàn)在安裝正確的布線基礎設施解決方案將使企業(yè)從一開始就獲得更大的經(jīng)濟利益,保留并吸引更多客戶,并使企業(yè)的數(shù)據(jù)中心設施能夠蓬勃發(fā)展。

京公網(wǎng)安備 11010502049343號

京公網(wǎng)安備 11010502049343號