交互設計工具網站Readme的老板格里高利·科貝格。

心理健康聊天機器人Woebot的創始人艾莉森·達西。

患者正在接受虛擬心理治療師艾莉(Ellie)的輔導。

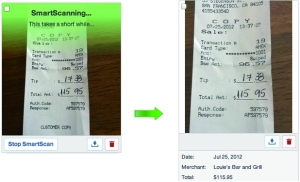

▲“智能掃描技術”(SmartScan)號稱能夠智能掃描出文字。

一些APP號稱可以將語音轉化成文字,結果卻是人工操作。

(上接B01版)

分析

為何對“偽人工智能”趨之若鶩?

隨后,《衛報》分析了這些科技企業對“偽人工智能”趨之若鶩的原因。

吸引關注和投資

首先便是裝成行業佼佼者,吸引關注和投資,“這是他們不會告訴投資者和用戶的秘密”。這其中又分兩種情況。一種是讓人類來協助已有的人工智能,比如牽涉到谷歌郵箱泄密的那些第三方App,再比如,美國有家叫Scale API的公司,雇了一大堆人幫自己的自動駕駛汽車校準傳感器。

再有便是對外假稱是AI技術,然后偷偷用人工代替,直到真的開發出這個AI之前,能混一天算一天。報道稱,真人雖然速度又慢,又不能批量處理任務,但畢竟便宜啊。

有趣的是,早在2016年,一家交互設計工具網站Readme的老板格里高利·科貝格便在推特上用玩笑的口吻曝光了這個黑幕。他說:

“如何創辦一家AI公司?

1.雇傭一批人類假裝AI,他們的工資能多低就多低。

2.坐等AI被開發出來。”

模擬AI的最終體驗

心理學家、心理健康聊天機器人Woebot的創始人艾莉森·達西表示,“你模擬它最終的體驗。很多時候,在人工智能背后,其實是有真人在背后,而不是一個算法。”

艾莉森·達西說,開發一個好的AI系統需要“大量的數據”,一些設計師想在投資之前知道他們開發的服務是否有足夠大的需求。

不過,她說,這種方法不適合像Woebot這樣的心理支持服務。“作為心理學家,我們需要遵循道德準則,不欺騙別人顯然應該是準則之一。”

《華爾街日報》13日再次評論了“偽人工智能”現象,稱其為“機器學習”熱潮和“零工經濟”相結合的產物。

難題

如何加強AI技術“透明度”?

此外,《衛報》認為還有一個不那么“功利”的原因。心理學家發現,當用戶以為自己面對的是機器人時,會更容易放下戒備。一旦涉及敏感話題,這種情況就更加明顯。

再說回谷歌郵件事件,如果大家聽說郵件只是被機器人偷看了,抵觸情緒定然會比得知真相后小得多。

對AI更容易放下戒備

類似情形還存在于醫療問診中、來自南加大的研究團隊用他們開發的虛擬心理治療師艾莉(Ellie)做了一番測試。他們發現,患有創傷后應激障礙的退伍軍人知道艾莉是個AI系統時,他們更容易表露自己的癥狀,假如他們得知是真人在背后操作機器,就沒那么容易了。

但是有些人認為,公司應該始終對自己的服務運營方式保持透明。

“我不喜歡這樣。這對我來說是不誠實,是欺騙。”一位被雇傭去假裝提供人工智能服務的員工透露,其實很多同行都有不同程度的抵觸情緒。“感覺我們被推到了幕后。我不喜歡一家公司使用我的勞動力,轉而向客戶撒謊,不告訴他們真正發生的事情。”

讓AI假裝自己是人類

確實掌握AI技術的谷歌,也在早前意識到了這個倫理難題。而他們的解決方案是:讓AI假裝自己是人類。

谷歌在5月初宣布,“谷歌助手”(Google Assistant)的新功能Google Duplex會在打電話時加入“嗯”、“呃”之類擬人的象聲詞。但這一改動迅速遭到強烈反對,用戶紛紛表示“這豈不騙得更厲害了”。

達西也對當時的設計很不滿,“萬一AI能模仿名人或政客的聲音,打出真假難辨的電話,那還得了?”

于是,谷歌隨后又做了改動,讓Google Duplex在對話一開始就自報機器人身份,加強AI技術“透明度”。

但達西指出,“人工智能已經讓人產生了很大的恐懼,在缺乏透明度的情況下,它并不能真正幫助人們進行對話。”

京公網安備 11010502049343號

京公網安備 11010502049343號