然而,你可能沒注意到的是,當開發者們共同致力于讓AI變得更像人時,有些創業公司卻打起來了另外的算盤:讓人冒充AI。

谷歌CEO介紹Duplex。圖片來源:Google

對于這些公司來說,這一招既可以省下大量的研發費用,還可以忽悠到投資。正如ReadMe公司的CEO格雷戈里·科貝格(Gregory Koberger)所說的那樣,“把活兒交給真人,能讓你跳過大量技術和業務發展方面的挑戰。”

他在推特上吐槽道:“如何建立一家AI創業公司?1.雇傭大量廉價勞動力假扮成假扮人類的AI。2.等著AI被發明出來。”

這種做法已經是業界周知的秘密了,但是大部分消費者還蒙在鼓里。

前不久,據《華爾街日報》報道,谷歌允許大量第三方應用的開發者讀取Gmail用戶的郵件。在被曝光的第三方公司中,圣何塞的艾迪森軟件公司(Edison Software)就在用假的AI。他們的AI工程師會瀏覽用戶的個人郵件,來改善所謂的“智能回復”功能。不過,他們的隱私政策并未提及人類會看到用戶的郵件。

其實,早在2008年,就有一家名為Spinvox的公司作假了。他們號稱能將語音留言轉化為文字,結果被指控這些工作都是海外電話中心的人工來完成的。

2016年,據彭博社報道,在X .ai和Clara這樣的日程應用公司,人類員工每天都要花12小時假扮AI聊天機器人。這項工作太令人頭腦發麻了,以至于員工們說他們期待機器人能真正取代人類。

2017年,業務支出管理應用Expensify承認,他們通過人工轉寫收據,而不像對外聲稱的那樣用“智能掃描技術”。掃描過的收據會被發布到亞馬遜的勞力眾包平臺Mechanical Turk上,然后接受低薪的人來閱讀和轉寫這些收據。

在某些情況下,人類被用于訓練AI系統,來提升AI的精確度。例如,名叫Scale的公司用大量的人類工作者,向自動駕駛系統和其他AI系統提供訓練數據。此外,谷歌的Duplex也用到了人類訓練者。

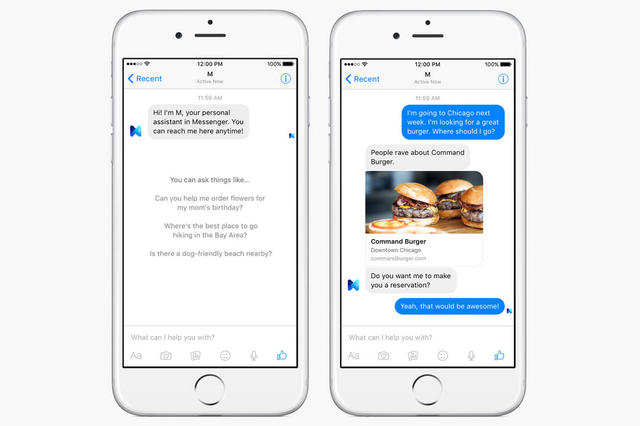

M聊天界面。圖片來源:Facebook

Facebook曾在2015年推出虛擬助手M的測試版。M能預約和提供禮物建議等,只不過,它也是由人工協助的。當時我們用不到它,因為它只對舊金山灣區的1萬人開放,而現在,Facebook徹底關閉了這一項目。雖然我們用不上它了,Facebook表示M的特性將會保留在聊天應用Messenger里。

這種人工協助AI的出發點其實是好的,AI系統會在人類的協助下學會應答各種指令,最終變得更加智能。然而,它的代價還是有點大。

首先,Facebook需要大量昂貴的勞動力,因此將服務擴大不太可行。其次,當M完成一項任務時,用戶總是會提出更難完成的要求。就這樣,M要達到的自動化程度遠遠超過了當前的機器學習技術。

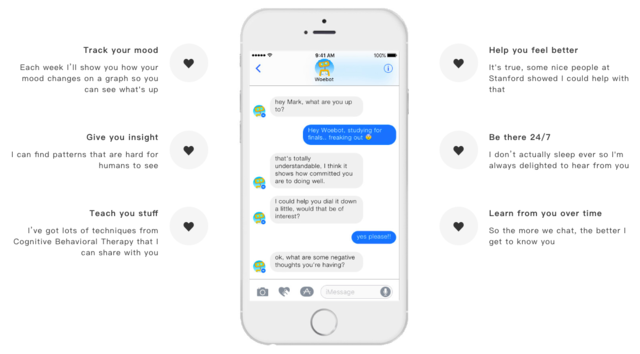

聊天機器人Woebot的創始人、心理學家艾莉森·達西(Alison Darcy)表示,這種方法并不適用于心理支持方面的服務,例如Woebot。

“作為心理學家,我們有倫理準則作為指導。其中,不去欺騙人們就是非常明確的一項。”

Woebot能夠向用戶提供精神健康方面的支持。圖片來源:Woebot

研究表明,當人們認為自己在和機器而非人類交談時,他們更愿意袒露心聲,這是因為精神衛生方面的求助常常和污名化聯系起來。南加州大學的研究團隊用虛擬心理咨詢師Ellie測試了這一研究。他們發現,當患有PTSD的退伍軍人知道Ellie是AI,而不是人類操作的機器時,他們更有可能坦誠講述自己的癥狀。

另外一些人認為,公司們應該一直公開自己的服務是如何運行的。

“我不喜歡人們假裝成AI。”羅謝爾·拉普蘭(Rochelle LaPlante)說,他為很多提供假AI服務的公司工作過。

“對于我來說,這不太誠實,而且有欺騙的意味。我希望自己正在使用的東西不是這樣的。而從工作者的角度來看,這就像是我們被推到了幕后。我不希望我提供勞動的公司轉變態度,而且向客戶隱瞞真相。”

這樣的道德困境也出現在試圖讓AI更像人類的項目中,例如谷歌的Duplex。該項目在最初演示的時候,AI 并沒有向打電話的對象表明身份。Duplex立刻引發了爭議,人們擔心這種略帶欺騙性的技術會被有心之人利用。

“人們對AI已經有很多主要的擔憂了,而缺乏透明并不能幫助我們解決問題。”達西說。

京公網安備 11010502049343號

京公網安備 11010502049343號