馬斯克:如果你不擔(dān)心人工智能的安全性,那么現(xiàn)在你應(yīng)該擔(dān)心。它比朝鮮核武器危險得多。

霍金:遠離 AI, 發(fā)明 AI 可能會成為人類歷史上最大的災(zāi)難,如果管理不善,會思考的機器可能會為文明劃上句號。

如今還沒等到 AI 具體應(yīng)用帶來的種種威脅,一盆涼水再次撲向如今正平穩(wěn)發(fā)展的 AI 領(lǐng)域,讓諸多想要入門 AI 的新手頓時迷失了方向,也讓全力投身于 AI 領(lǐng)域的創(chuàng)業(yè)者開始了恐慌。近日,計算機視覺及 AI 領(lǐng)域?qū)<?FILIP PIEKNIEWSKI 發(fā)布了一篇《AI Winter Is Well On Its Way》(AI 寒冬將至)的文章,他指出深度學(xué)習(xí)已塵埃落定、不具有擴展性、自動駕駛已奔潰,并最終預(yù)測 AI 寒冬就像預(yù)測股市的崩盤一樣,雖然不可能預(yù)測它何時會發(fā)生,但幾乎可以肯定它一定會發(fā)生,而且很快降臨。

接下來,我們將共同解讀《AI Winter Is Well On Its Way》的具體內(nèi)容,并分享國內(nèi)外大牛對于此事的看法,一窺 AI 寒冬是否真的到來?

很多年以來,深度學(xué)習(xí)一直處于所謂的人工智能革命的前沿,很多人認為深度學(xué)習(xí)是帶我們走進科技奇點(通用人工智能)的必勝法寶。2014、2015 和 2016 年間,很多公司都對深度學(xué)習(xí)深信不疑,他們積極地開拓新的疆域,例如 Alpha Go 等。特斯拉等公司的 CEO 宣布全自動駕駛汽車很快就能實現(xiàn),特斯拉甚至開始向客戶預(yù)售全自動駕駛功能(將來可以通過軟件激活該功能)。

而現(xiàn)在 2018 年已經(jīng)過去了一半,情況發(fā)生了變化。雖然表面上還看不出來,神經(jīng)信息處理系統(tǒng)大會(Neural Information Processing Systems,簡稱 NIPS)仍然一票難求,特斯拉在新聞發(fā)布會上還頻頻提及人工智能,CEO 埃隆·馬斯克仍然信守關(guān)于自動駕駛汽車的諾言,Google 的 CEO 仍堅守吳恩達的口號:人工智能將帶來比電力革命更偉大的變革。但是這種說法已開始動搖。我曾經(jīng)表示過,這種動搖最明顯的地方應(yīng)該是無人駕駛,這正是人工智能科技在現(xiàn)實世界中的一項真實應(yīng)用。

▌深度學(xué)習(xí)的塵埃已定

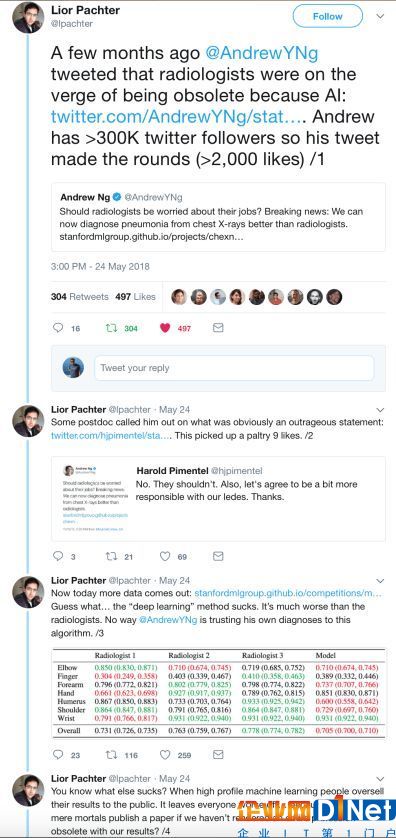

當 ImageNet 得到有效解決后(請注意這并不意味著視覺問題得到了解決),該領(lǐng)域許多出色的研究人員(甚至包括向來低調(diào)的 Geoffrey Hinton)都活躍在媒體的采訪中,在社交媒體上做宣傳(例如 Yann Lecun、吳恩達、李飛飛等)。總基調(diào)無非是我們面臨巨大的革命,今后技術(shù)的發(fā)展只會更快。很多年過去了,這些人在 Twitter 上也沒那么活躍了,以吳恩達為例來說:

2013年:日均推文0.413條

2014年:日均推文0.605條

2015年:日均推文0.320條

2016年:日均推文0.802條

2017年:日均推文0.668條

2018年:日均推文0.263條(截至5月24日)

也許這是因為吳恩達語出驚人的言論現(xiàn)在被社區(qū)更加嚴格地審查,如下面的推文所示:

很明顯公眾的情緒已經(jīng)大幅減弱了,稱贊深度學(xué)習(xí)為終極算法的推文少了很多,論文的基調(diào)也由“變革”向“進化”轉(zhuǎn)變。繼 Alpha Go Zero 以來,DeepMind 再也沒有出過舉世震驚的新聞,而且如果考慮下 Alpha Go Zero 所需的巨大計算量以及只能應(yīng)用于游戲的局限性,似乎它也并沒有那么讓人激動。OpenAI 非常沉寂,上次他們在媒體上大放異彩是由于在 Dota 2 的游戲中擊敗了人類選手(我以為這會像 Alpha Go 引起世界的轟動,但是這則消息轉(zhuǎn)瞬即逝了)。事實上,很多文章開始提出,就連 Google 都不知道該如何發(fā)展 DeepMind 了,因為 DeepMind 的結(jié)果在實踐顯然并沒有達到預(yù)期。而對于那些出色的研究人員,他們與加拿大和法國政府官員會晤,為的是保證他們將來的撥款,而 Yann Lecun 甚至卸任了 Facebook 人工智能研究負責(zé)人一職,轉(zhuǎn)而擔(dān)任 Facebook 人工智能首席科學(xué)家。從有錢的大公司到政府資助的研究機構(gòu)的逐步轉(zhuǎn)變讓我意識到,這些公司(我指的是 Google 和 Facebook)對這種研究的熱潮實際上正在逐步消退。這些都是早期的征兆,雖然未表于言辭,但是大家都心領(lǐng)神會了。

▌深度學(xué)習(xí)不具有擴展性

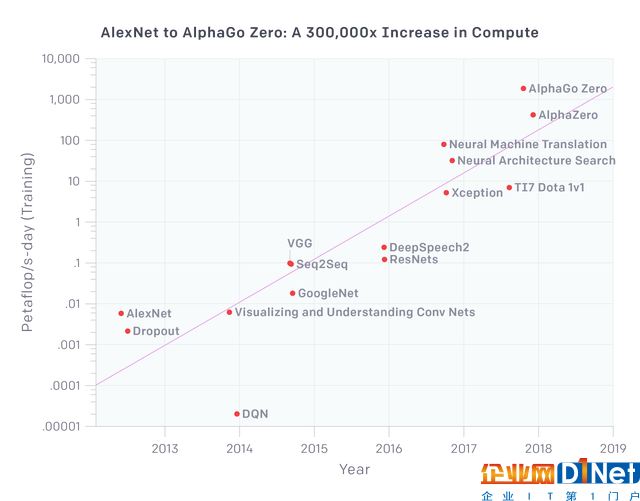

關(guān)于深度學(xué)習(xí)的一個關(guān)鍵的口號是它可以輕而易舉的擴展規(guī)模。2012 年 AlexNet 問世,它擁有將近 6000 萬個參數(shù),現(xiàn)在我們的模型的參數(shù)不是至少是 AlexNet 的 1000 倍了吧?也許沒錯,但問題是這些模型的功能有 1000 倍嗎?或者,有 100 倍嗎?我們用 OpenAI 的一項研究來做說明:

圖:AlexNet 到 Alpha Go Zero:計算量提高了 30 萬倍

關(guān)于視覺方面的應(yīng)用,我們看到 VGG 和 Resnets 在應(yīng)用的計算資源增加一個數(shù)量級時趨于飽和(它們的參數(shù)數(shù)量其實還比較少)。Xception 是 Google 的 inception 架構(gòu)的一個變種,它在 ImageNet 上的表現(xiàn)只比 inception 好一點點,實際上可能略微勝過所有其他模型,因為從根本上來說是 AlexNet 解決了 ImageNet 的問題,所以,如果投入 AlexNet 的 100 倍的計算力,我們基本上可以說視覺(準確來說是圖像分類)架構(gòu)都將趨于飽和。所有大型網(wǎng)絡(luò)搜索引擎公司都在神經(jīng)網(wǎng)絡(luò)機器翻譯上付出了巨大努力,為此他們投入了所有可用的計算資源。但即使如此,Google 翻譯依然做得很差(雖然很多人認為它比以前進步了很多)。上圖最右邊的三個點顯示了與強化機器學(xué)習(xí)有關(guān)的項目,Deepmind 和 OpenAI 開發(fā)的游戲中運用了該技術(shù)。尤其是 AlphaGo Zero 和更為通用的 AlphaZero 使用了難以想象的計算力,但是大部分計算力都用來模擬和生成模型所需的海量數(shù)據(jù),所以這種擴展在現(xiàn)實世界中毫無無用武之地。雖說現(xiàn)在我們無需花費幾天的時間,只需幾分鐘就可以訓(xùn)練好 AlexNet,但是我們可以在幾天內(nèi)訓(xùn)練好 AlexNet 的 1000 倍的模型并得到相對較好的結(jié)果嗎?很顯然不能……

所以事實上,雖說上圖旨在演示深度學(xué)習(xí)具有良好的擴展性,而結(jié)果卻恰恰相反。我們無法簡單地擴大 AlexNet 的規(guī)模并獲得相對將好的結(jié)果,我們必須處理具體的架構(gòu),并且如果不能提升樣本數(shù)據(jù)的數(shù)量級(僅在模擬游戲環(huán)境中才可行)的話,那么額外的有效計算力也毫無意義。

▌自動駕駛的崩潰

到目前為止,對深度學(xué)習(xí)的名聲打擊最大的是自動駕駛汽車(我曾從事于自動駕駛很長時間)。最初大家以為,NVIDIA 大力推廣的端到端的深度學(xué)習(xí)能夠解決該問題。我覺得如今這個世界上已經(jīng)沒人相信這個觀點了(但是也有可能是我錯了)。去年加利福尼亞車輛管理局的脫離報告顯示,NVIDIA 車輛每次脫離人工控制連 10 英里都行駛不了。我曾在另外一篇文章中討論過自動駕駛發(fā)展的總體情況,并與人類駕駛員的安全性進行了比較,結(jié)果都不太妙。自 2016 年以來,特斯拉的自動導(dǎo)航系統(tǒng)(AutoPilot)發(fā)生了多起事故,其中幾起事故還是致命的。雖說我們不應(yīng)該將特斯拉的自動導(dǎo)航系統(tǒng)與自動駕駛車輛混為一談,但是至少它們的核心技術(shù)都是相同的。到目前為止,除了偶爾出現(xiàn)的嚴重錯誤以外,還常常發(fā)生在十字路口停不下來,無法識別紅綠燈,甚至無法繞環(huán)島正確行駛。到 2018 年 5 月,距離特斯拉承諾的無人駕駛車輛穿越美國行駛(這一承諾未能實施,但有傳聞?wù)f他們嘗試了 30 次脫離,終究未能成功,)已經(jīng)過去好幾個月了。幾個月以前(2018年2月)當問及穿越美國行駛計劃時,埃隆·馬斯克反復(fù)說:

“我們本來可以實現(xiàn)穿越美國行駛計劃,但這需要太多專門的代碼來有效實現(xiàn),但是代碼太過具體又會讓系統(tǒng)太脆弱,只能在某條具體的路線上很好地行駛,但不是通用的解決方案。所以我認為我們可以重復(fù)行駛某條線路,但是如果無法找到對所有路線都通用的方法的話,就不能算是真的解決方案。”

“我對我們在神經(jīng)網(wǎng)絡(luò)方面的進步感到非常激動。而且凡事都要經(jīng)歷從量變到質(zhì)變的過程,現(xiàn)在我們看不到進步,但是經(jīng)過日積月累,終有一天驚喜會出現(xiàn)。我們的自動駕駛看起來是個很蹩腳的駕駛員,但是逐步會變成還不錯的駕駛員,而終有一天人們會驚喜地發(fā)現(xiàn)這個駕駛員好厲害。”

然而,從上圖(從OpenAI)中我并沒有看到突破性的發(fā)展。而且從脫離人工控制的里程數(shù)角度來看,沒有任何一家大廠商做出了顯著的進步。實際上上面的聲明應(yīng)該解讀為:“我們目前沒有什么技術(shù)能夠安全地實現(xiàn)穿越美國,雖然我們其實可以作假……我們深刻希望神經(jīng)網(wǎng)絡(luò)的能力能在短期內(nèi)出現(xiàn)指數(shù)級的增長,從而把我們從恥辱和各種官司中拯救出來。”

然而到目前為止,戳破 AI 泡沫的最大事件就是在亞利桑那州發(fā)生的 Uber 的自動駕駛導(dǎo)致行人死亡的事故。從 NTSB 的初步報告中我們可以看到一些令人震驚的情況:

根據(jù)從自動駕駛系統(tǒng)中獲得的數(shù)據(jù),系統(tǒng)在碰撞發(fā)生大約 6 秒前就在雷達和 LIDAR 觀察系統(tǒng)中登記了行人,當時車輛速度為 43mph。隨著車輛和行人的接近,自動駕駛系統(tǒng)軟件將行人分類為不明物體,然后分類為車輛,再分類為可能會有不同路線的自行車。直到碰撞前 1.3 秒,自動駕駛系統(tǒng)才確定必須通過緊急剎車才能避免碰撞。據(jù) Uber 說,當車輛處于電腦控制時,緊急剎車操作并不會被啟用,以減少不穩(wěn)定的車輛行為的可能性。汽車依賴于駕駛員來干預(yù)并采取措施。而該系統(tǒng)中并沒有警告駕駛員的設(shè)計。

拋開報告中提到的一般系統(tǒng)設(shè)計上的失敗不說,在這種情形下該系統(tǒng)不是只做邏輯判斷確保不會發(fā)生碰撞,而是需要長達數(shù)秒的時間來判斷前方物體究竟是什么,是行人、自行車、車輛或其他。這其中有幾個原因:首先,人們總喜歡事后諸葛亮。所以大家經(jīng)常說:“我看到一輛自行車,所以我向左打輪避開了他。”大量心理物理學(xué)文獻卻有完全不同的解釋:“人類在看到某樣?xùn)|西時,神經(jīng)系統(tǒng)的快速感知回路將迅速將其解釋為障礙物,然后人就會采取迅速的行動來避免障礙物,幾秒鐘后才意識到發(fā)生的情形,并作出語言上的解釋。”日常生活中我們每天要做出大量的決定而沒有表述出來,而駕駛包含很多的這些決定。用語言表達的代價很大,而且耗時,現(xiàn)實無法提供足夠的時間。這些人類的身體機能通過十億年的進化,保障我們的安全,而現(xiàn)代才出現(xiàn)的駕駛利用了許多這樣的反射。既然這些反射并沒有為駕駛技術(shù)經(jīng)歷專門的進化,所以可能會引發(fā)錯誤。車里的一只黃蜂可能引起駕駛員的膝跳反射,這可能會引起許多撞車和死亡事件。但是我們通常對三維空間、速度、預(yù)測能力、橫穿馬路的物體的理解是身體原始的技能,從一億年前至今這些原始技能對人類一直非常有幫助,并且在經(jīng)歷了進化后更加靈敏。

但是由于大部分這些技能都無法用言辭表達,很難衡量,所以我們根本無法在這些方面上優(yōu)化機器學(xué)習(xí)系統(tǒng)。現(xiàn)在用 NVIDIA 所倡導(dǎo)的端到端的方法,即從學(xué)習(xí)圖形到映射行動,跳過言辭表達,從某些方面來說這固然沒錯,但是問題在于輸入空間的維度異常高,但行動空間的維度卻非常低。因此相對于巨大的輸入信息量,“標簽”的“數(shù)量”非常小。在這種情況下,模型很容易學(xué)習(xí)到虛假的關(guān)系,例如深度學(xué)習(xí)中的對抗樣本就證明了這一點。因此,我們需要一個不同的范式,且前提條件是可以預(yù)測整個感知的輸入,而模型采取第一步是讓系統(tǒng)能夠從現(xiàn)實世界抽取語義,而不是虛假的相互關(guān)系。

事實上,如果非要說我們從如火如荼的深度學(xué)習(xí)中學(xué)到了什么的話,那就是一萬維的圖像中包含了許多虛假的模式,而這些模式在許多圖像中都會出現(xiàn),因此會給我們造成一種假象,那就是分類器似乎理解了它看到的圖像。而實際上真實情況遠非如此,該領(lǐng)域的許多頂尖的研究者在經(jīng)過深入研究后承認了這一點。實際上,許多頂尖研究者應(yīng)該不會對我的觀點感到驚訝。Yann Lecun 曾經(jīng)警告,不要對 AI 感到過度興奮,而且 AI 的冬天即將來臨;甚至連當前流行的反向傳播算法之父 Geoffrey Hinton 都在一次談話中說過,有可能這一切都通向一條死路,而我們不得不重新開始。但在目前來看,媒體的大肆宣傳使得沒人愿意聽這些言論,就算是 AI 之父的言論也沒人聽。

▌Gary Marcus 和他對宣傳的反抗

其實越是處于高層次的人,越能看出這種傲慢,并且有勇氣公開說出來。該領(lǐng)域最活躍的專家之一就是 Gary Marcus。盡管我并不同意他對 AI 的全部看法,但我們必須要承認,AI 還沒有媒體對于深度學(xué)習(xí)宣傳的那樣強大。實際上還差得很遠。Gary Marcus 有一篇精彩的博文和論文《深度學(xué)習(xí):深刻的估計》(https://arxiv.org/abs/1801.00631)和《針對深度學(xué)習(xí)的懷疑論的回答》(https://medium.com/@GaryMarcus/in-defense-of-skepticism-about-deep-learning-6e8bfd5ae0f1)向人們說明這一點,在這兩篇文章中,他細心地解釋了深度學(xué)習(xí)的熱潮。我很尊敬 Gary,他的行為才是真正的科學(xué)家應(yīng)有的行為,而許多所謂的“深度學(xué)習(xí)明星”的行為就像是個廉價的名人而已。

▌結(jié)論

預(yù)測 AI 的寒冬就像預(yù)測股市的崩盤一樣,雖然不可能預(yù)測它何時會發(fā)生,但幾乎可以肯定它一定會發(fā)生。就像在股市崩盤之前總會有各種各樣的信號,但媒體宣傳過于強大,以致很多人都會忽視這些信號,即使這些信號很明顯。在我看來,深度學(xué)習(xí)被大幅度冷落的信號已經(jīng)相當明顯(或許也包括 AI,由于這個詞已經(jīng)被各大企業(yè)的宣傳濫用了),只不過仍在不斷炒作的媒體們看不到而已。這個冬天將有多久?我不知道。之后會是什么?我也不知道。但我很肯定,冬天一定會來臨,而且很可能會很快降臨。

▌AI 寒冬是否真的來臨?

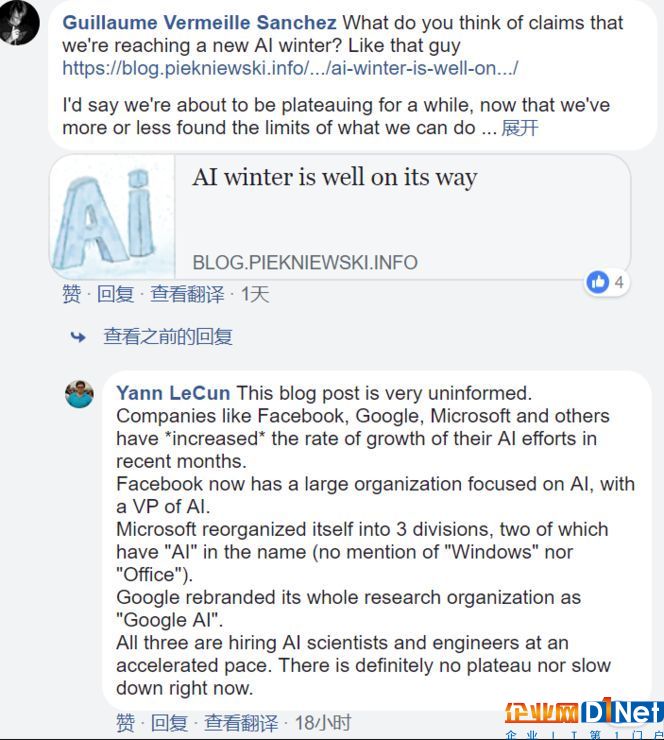

針對此番看似過激的言論,很多人一時之間也摸不清頭腦,AI 領(lǐng)域的專家們也看法不一。身為文章中提及關(guān)鍵人物之一的 Facebook 首席科學(xué)家 Yann LeCun 看到這篇文章后,進行了否定,他表示:

這篇文章純屬無稽之談,F(xiàn)acebook、Google、Microsoft 以及其他公司正緊密地加強 AI 布局。

Facebook 現(xiàn)在擁有一個專注于 AI 研究的團隊。

Microsoft 事業(yè)部有三個部門,其中兩個包含了“AI”名稱(并沒有提及“Windows”或“Office”)。

Google 將其整個研究院重命名為“Google AI”。

三家巨頭在大力地招聘 AI 科學(xué)家及工程師,并沒有看出減速現(xiàn)象。

國內(nèi),中科院院士譚鐵牛實力反擊 AI 寒冬言論,表示:人工智能的春天剛剛開始,未來十年,人工智能將是最具變革性的技術(shù)。今天,人工智能如日中天,火遍全球的當下,實事求是地設(shè)定科學(xué)目標顯得尤為重要。

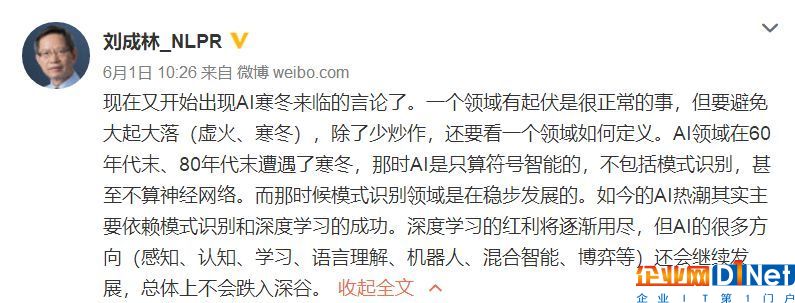

此外,中國科學(xué)院自動化研究所工學(xué)博士、研究員劉成林表示,一個領(lǐng)域的起伏是很正常的事情,如今只是深度學(xué)習(xí)的紅利將逐漸用盡,但 AI 領(lǐng)域還有很多其他的方向,譬如感知、認知、學(xué)習(xí)、語言理解、機器人、混合智能、博弈等等。

AI 寒冬是否真的來臨?在此筆者想到丘吉爾曾說過,「你能看到多遠的過去,就能看到多遠的未來」,AI 在過去六十多年的發(fā)展歷程中,已經(jīng)遭遇了兩次寒冬期,而近幾年隨著深度學(xué)習(xí)的成功運用才再次火熱,如今深度學(xué)習(xí)或許正在面臨瓶頸期,最終也只是將人工智能帶回平穩(wěn)的道路上。所謂的寒冬論,也僅僅是一門技術(shù)的過渡期而已。對于此問題, Hacker News (https://news.ycombinator.com/item?id=17184054)上的網(wǎng)友們也表示:

對此,你怎么看呢?

京公網(wǎng)安備 11010502049343號

京公網(wǎng)安備 11010502049343號